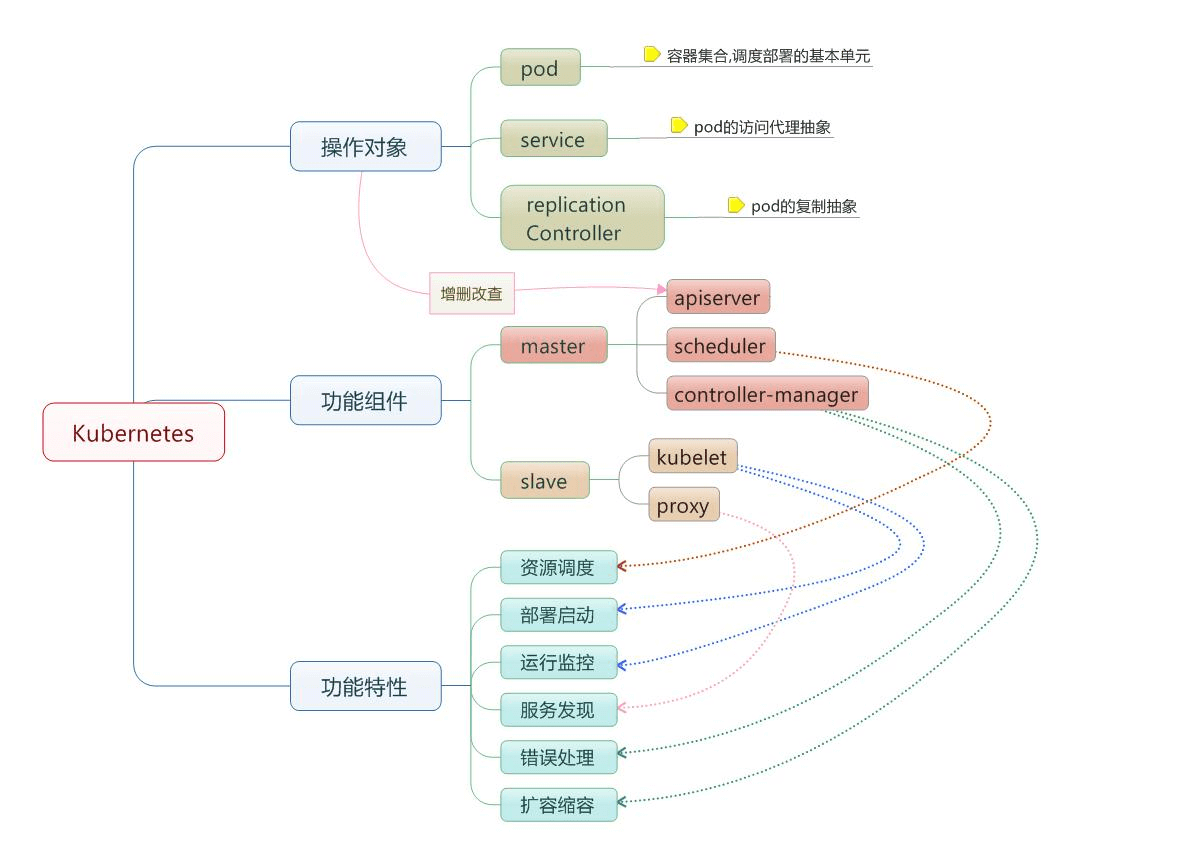

Kubernetes简介

kubernetes是可移植、可扩展、开源的容器管理平台,是谷歌Borg的开源版本,简称k8s,它可以创建应用、更新应用、回滚应用,也可实现应用的扩容缩容,做到故障自恢复。

可移植:基于镜像可从一个环境迁移到另一个环境

可扩展:k8s集群可以横向扩展、根据流量实现自动扩缩容

开源的:源代码已经公开了,可以被用户免费使用,可以二次开发

可以对容器自动化部署、自动化扩缩容、跨主机管理等;

可以对代码进行灰度发布、金丝雀发布、蓝绿发布、滚动更新等;

具有完整的监控系统和日志收集平台,具有故障自恢复的能力。

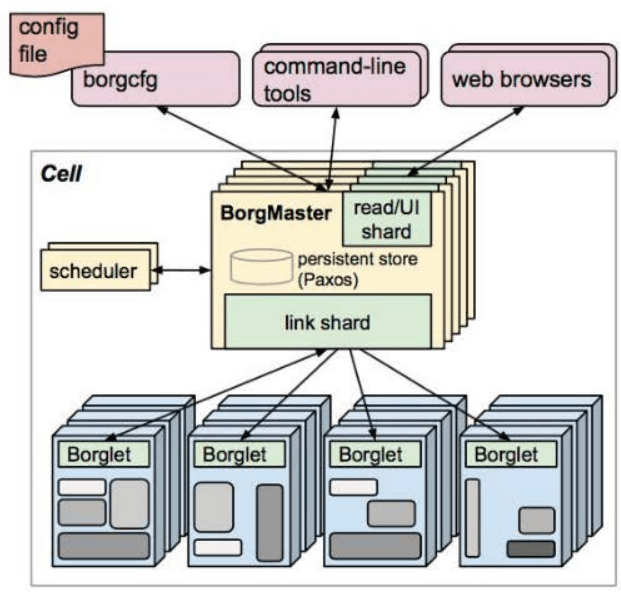

kubernetes起源

Borg是谷歌内部的一个容器编排工具,谷歌业务90%以上都在Borg上运行,Borg在谷歌内部已经使用了大概15年。 K8S是在Borg的基础上开发出来的轻量级容器编排工具。K8S的根基非常牢固,得益于Borg过去十数年间积累的经验和教训,是站在巨人的肩膀上发展起来的项目。开源之后,迅速称霸容器编排技术领域。

Google Borg架构

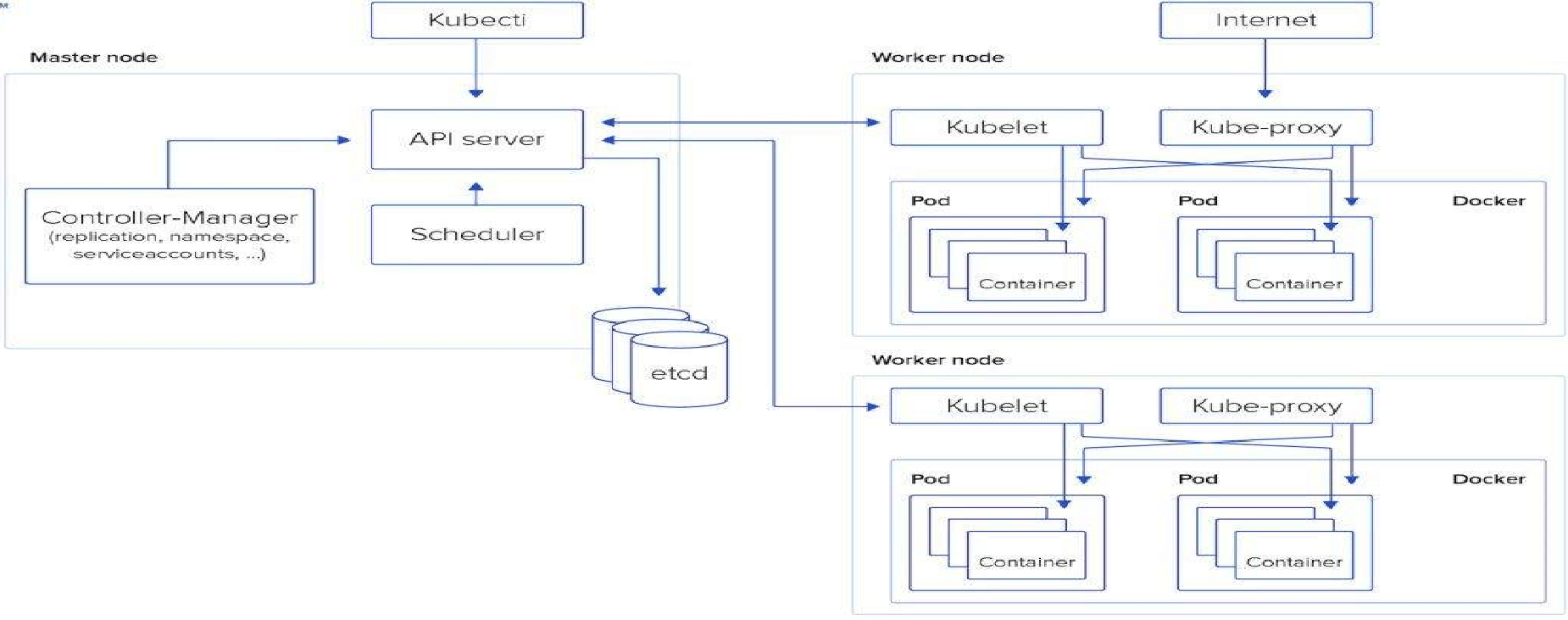

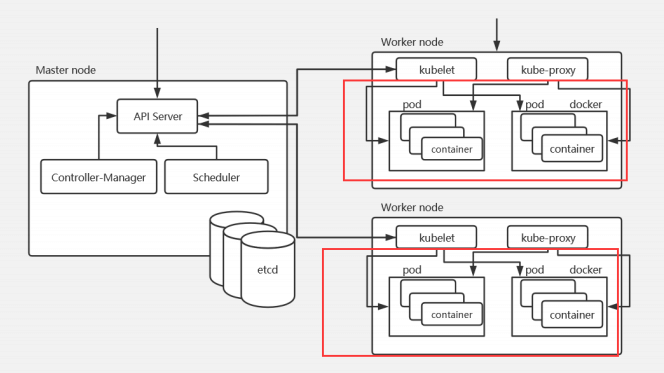

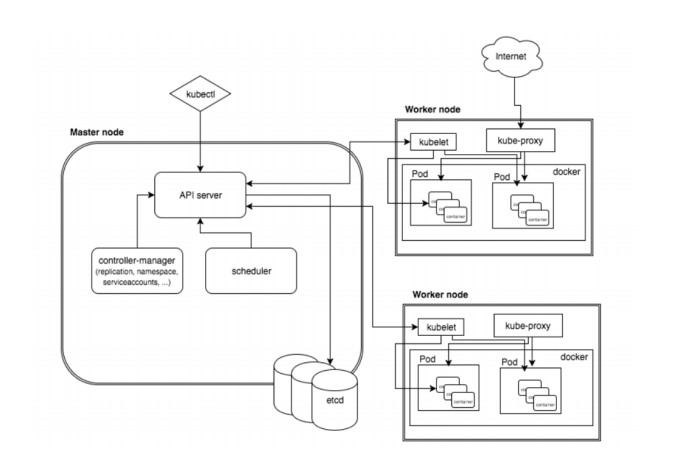

Kubernetes架构

k8s的物理架构是master/node模式:

K8S集群至少需要一个主节点(Master)和多个工作节点(Worker),Master节点是集群的控制节点,负责整个集群的管理和控制,主要用于暴露API、调度部署和对节点进行管理。工作节点主要是运行容器的。

单master节点架构图

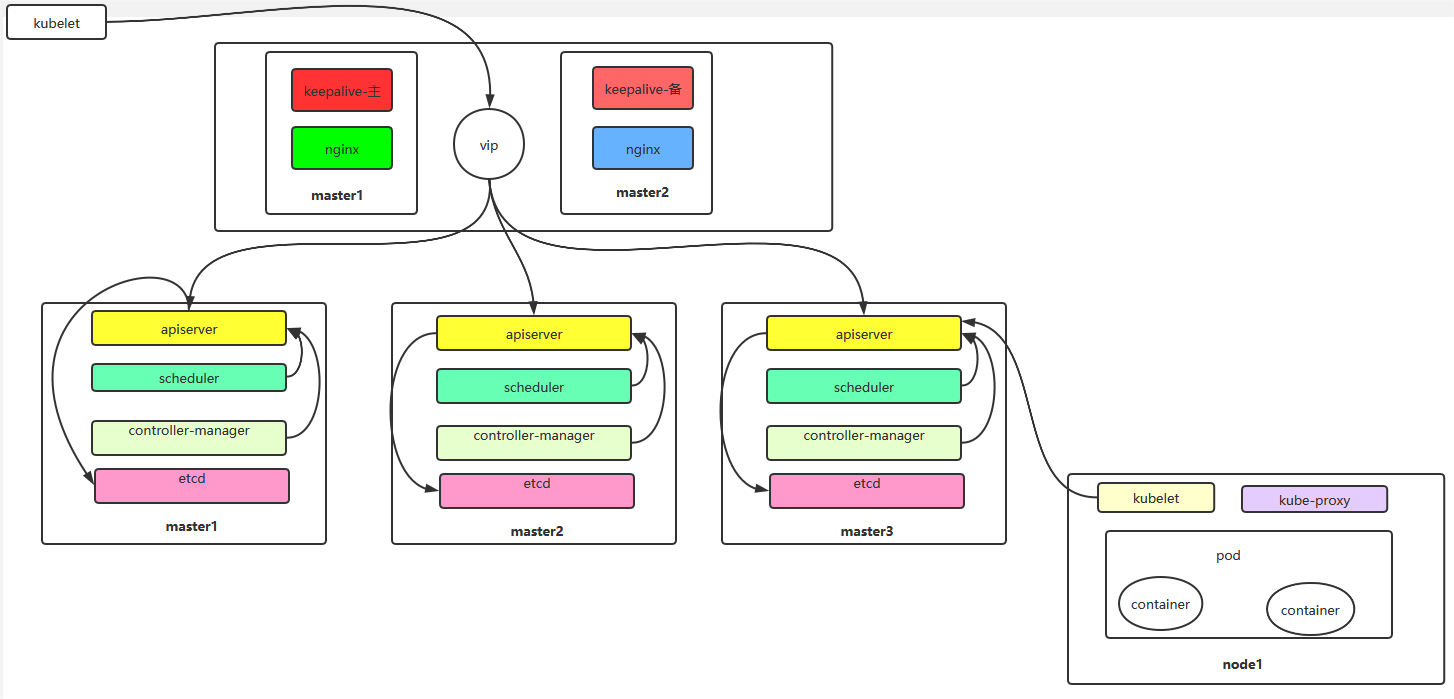

多master节点架构图

Kubernetes组件 Master node

apiserver

scheduler

controller-manager

Etcd

calico

docker

Work node

kubelet

kube-proxy

Calico

Coredns

docker

各组件解析

kubectl

管理k8s的命令行工具,可以操作k8s中的资源对象,如增删改查等。

etcd

是一个高可用的键值数据库,存储k8s的资源状态信息和网络信息的,etcd中的数据变更是通过api server进行的。

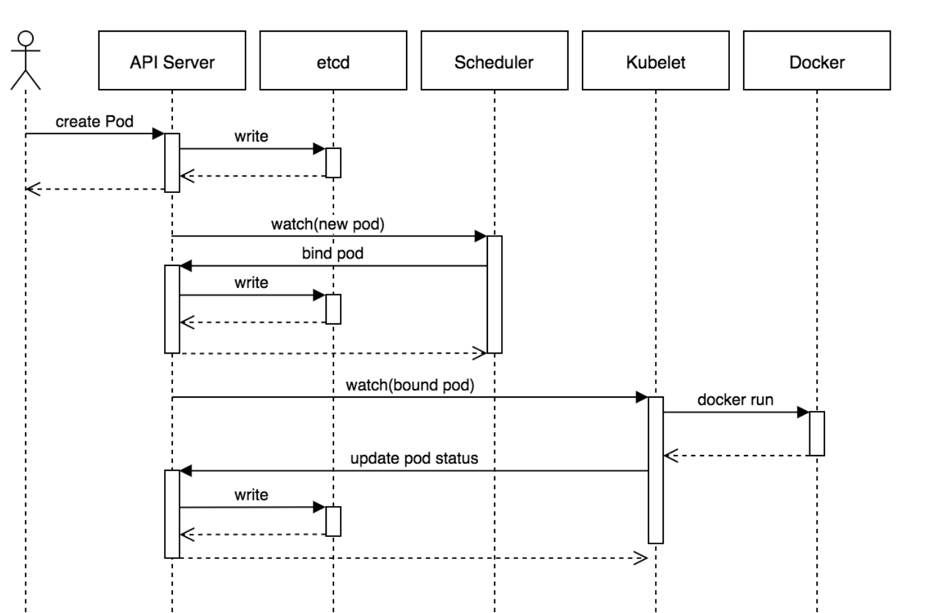

apiserver

提供k8s api,是整个系统的对外接口,提供资源操作的唯一入口,供客户端和其它组件调用,提供了k8s各类资源对象(pod,deployment,Service等)的增删改查,是整个系统的数据总线和数据中心,并提供认证、授权、访问控制、API注册和发现等机制,并将操作对象持久化到etcd中。

scheduler

负责k8s集群中pod的调度的 , scheduler通过与apiserver交互监听到创建Pod副本的信息后,它会检索所有符合该Pod要求的工作节点列表,开始执行Pod调度逻辑。调度成功后将Pod绑定到目标节点上,相当于“调度室”。

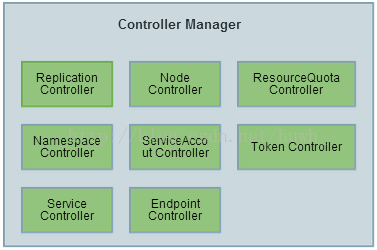

Controller-Manager

作为集群内部的管理控制中心,负责集群内的Node、Pod副本、服务端点(Endpoint)、命名空间(Namespace)、服务账号(ServiceAccount)、资源定额(ResourceQuota)的管理,当某个Node意外宕机时,Controller Manager会及时发现并执行自动化修复流程,确保集群始终处于预期的工作状态。

每个Controller通过API Server提供的接口实时监控整个集群的每个资源对象的当前状态,当发生各种故障导致系统状态发生变化时,会尝试将系统状态修复到“期望状态”。

kubelet

每个Node节点上的kubelet定期就会调用API Server的REST接口报告自身状态,API Server接收这些信息后,将节点状态信息更新到etcd中。kubelet也通过API Server监听Pod信息,从而对Node机器上的POD进行管理,如创建、删除、更新Pod

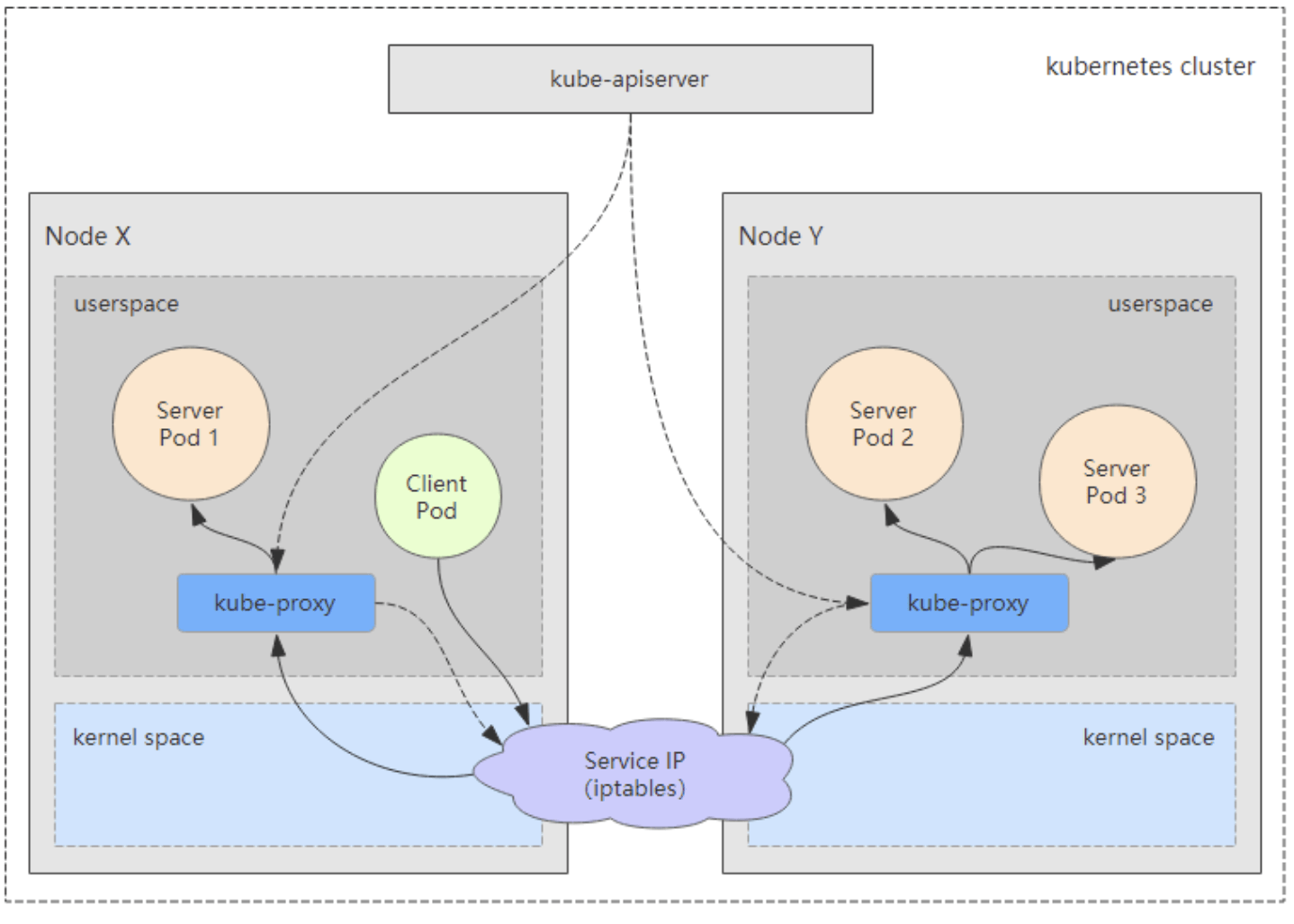

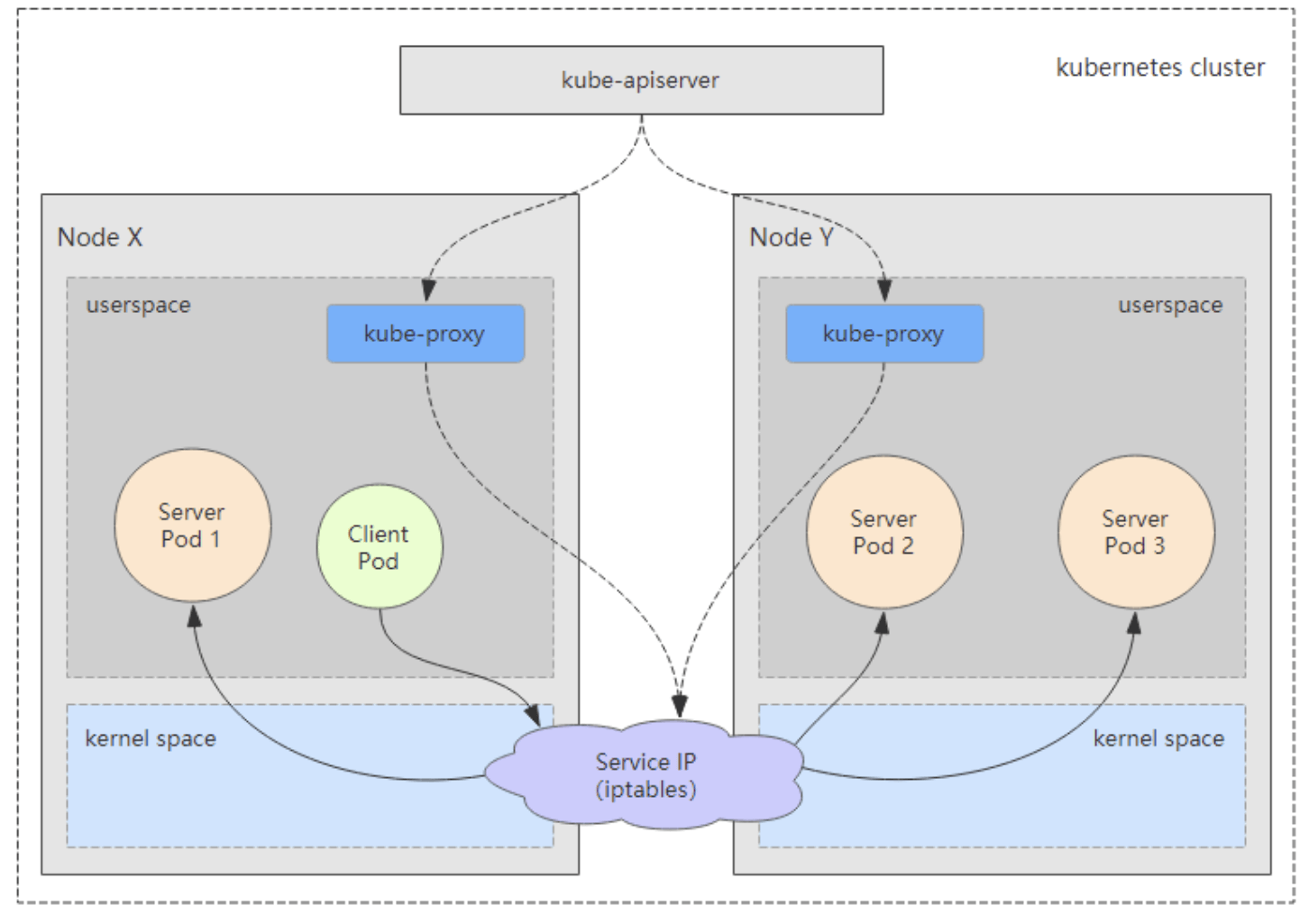

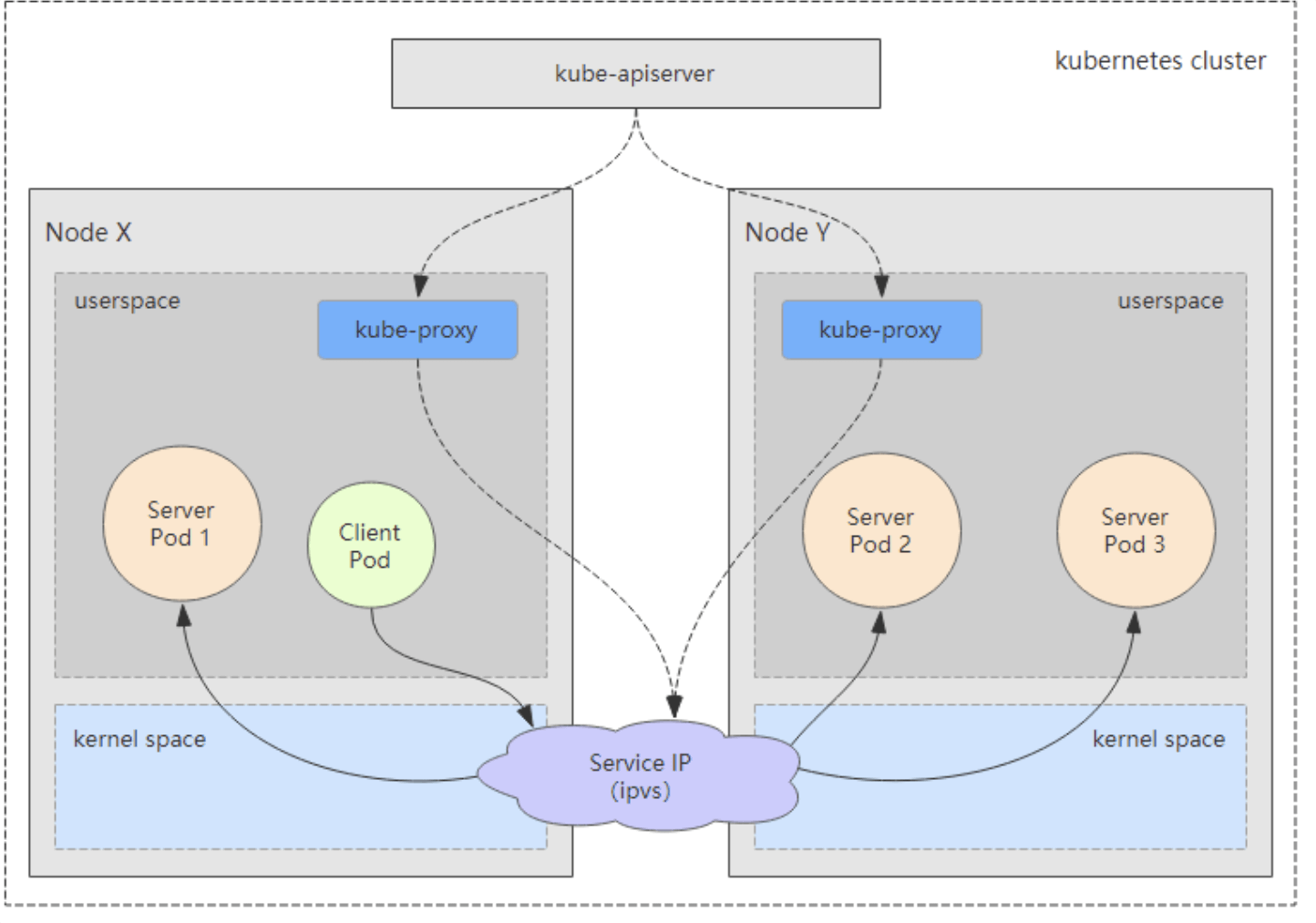

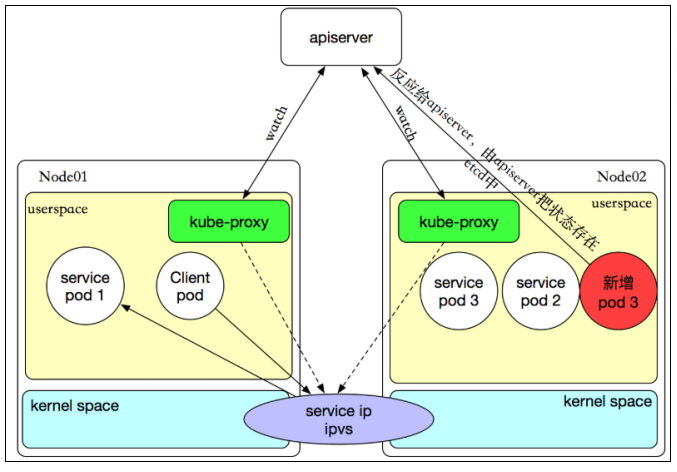

kube-proxy

提供网络代理和负载均衡,是实现service的通信与负载均衡机制的重要组件,kube-proxy负责为Pod创建代理服务,从apiserver获取所有service信息,并根据service信息创建代理服务,实现service到Pod的请求路由和转发,从而实现K8s层级的虚拟转发网络,将到service的请求转发到后端的pod上。

Cordns

CoreDNS 其实就是一个 DNS 服务,而 DNS 作为一种常见的服务发现手段,很多开源项目以及工程师都会使用 CoreDNS 为集群提供服务发现的功能,Kubernetes 就在集群中使用 CoreDNS 解决服务发现的问题。

Calico

是一套开源的网络和网络安全方案,用于容器、虚拟机、宿主机之前的网络连接,可以用在kubernetes、OpenShift、DockerEE、OpenStrack等PaaS或IaaS平台上。

Docker

容器运行时,负责启动容器的,在k8s1.20版本之后建议废弃docker,使用container作为容器运行时

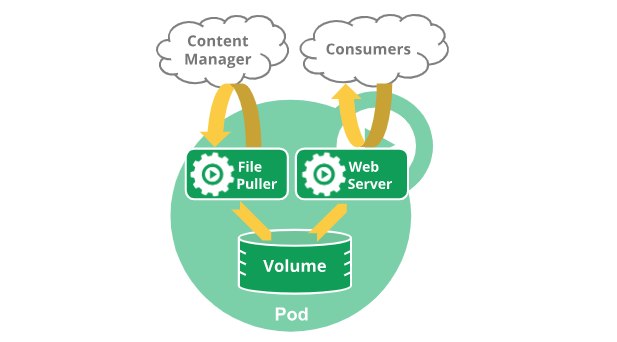

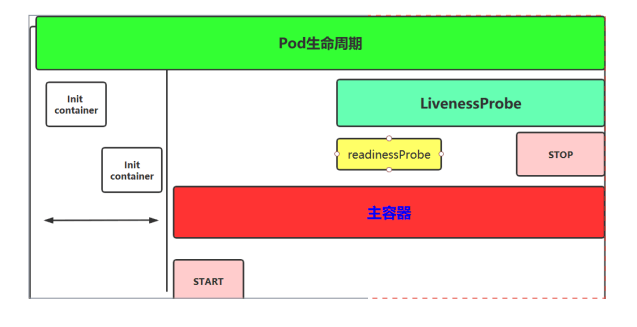

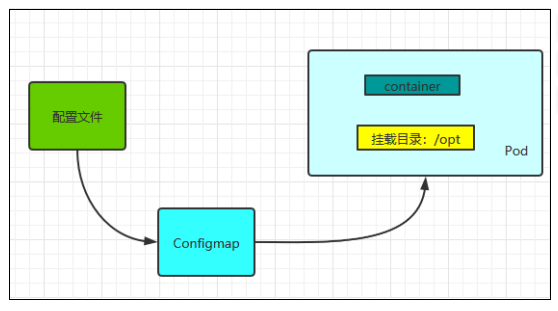

Kubernetes核心资源解读 Pod

Pod是Kubernetes中的最小调度单元,k8s是通过定义一个Pod的资源,然后在Pod里面运行容器,容器需要指定镜像,用来运行具体的服务。

Pod代表集群上正在运行的一个进程,一个Pod封装一个容器(也可以封装多个容器),Pod里的容器共享存储、网络等。

也就是说,应该把整个pod看作虚拟机,然后每个容器相当于运行在虚拟机的进程。

可以把pod看成是一个“豌豆荚”,里面有很多“豆子”(容器)。一个豌豆荚里的豆子,它们吸收着共同的营养成分、肥料、水分等,Pod和容器的关系也是一样,Pod里面的容器共享pod的网络、存储等。

在K8s中,所有的资源都可以使用一个yaml配置文件来创建,创建Pod也可以使用yaml配置文件

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 ~]# cat pod.yaml apiVersion: v1 kind: Pod metadata: name: tomcat-pod namespace: default labels: tomcat: tomcat-pod spec: containers: - name: tomcat-pod-java ports: - containerPort: 8080 image: tomcat:8.5-jre8-alpine imagePullPolicy: IfNotPresent ~]# kubectl apply -f pod.yaml ~]# kubectl get pods -l tomcat=tomcat-pod NAME READY STATUS RESTARTS AGE tomcat-pod 1 /1 Running 0 9s

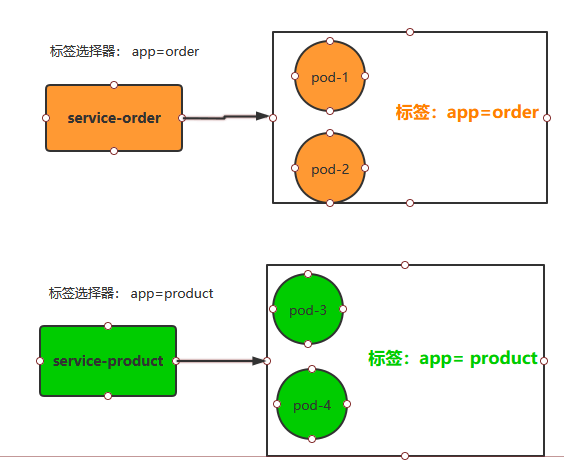

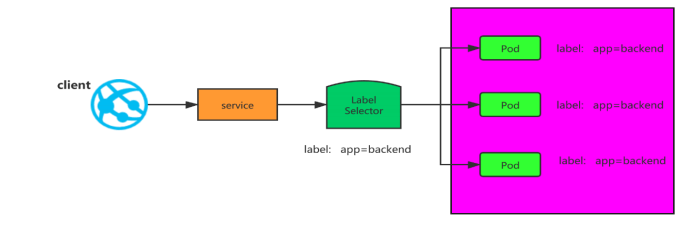

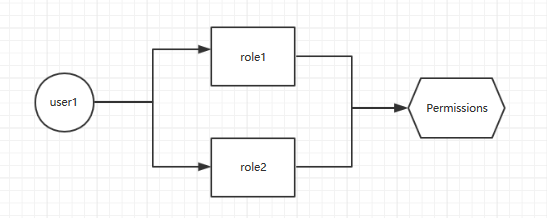

label

label是标签的意思,k8s中的资源对象大都可以打上标签,如Node、Pod、Service 等,一个资源可以绑定任意多个label,k8s 通过 Label 可实现多维度的资源分组管理,后续可通过 Label Selector 查询和筛选拥有某些 Label 的资源对象

例如创建一个 Pod,给定一个 Label是app=tomcat,那么service可以通过label selector选择拥有app=tomcat的pod,和其相关联,也可通过 app=tomcat 删除拥有该标签的 Pod 资源

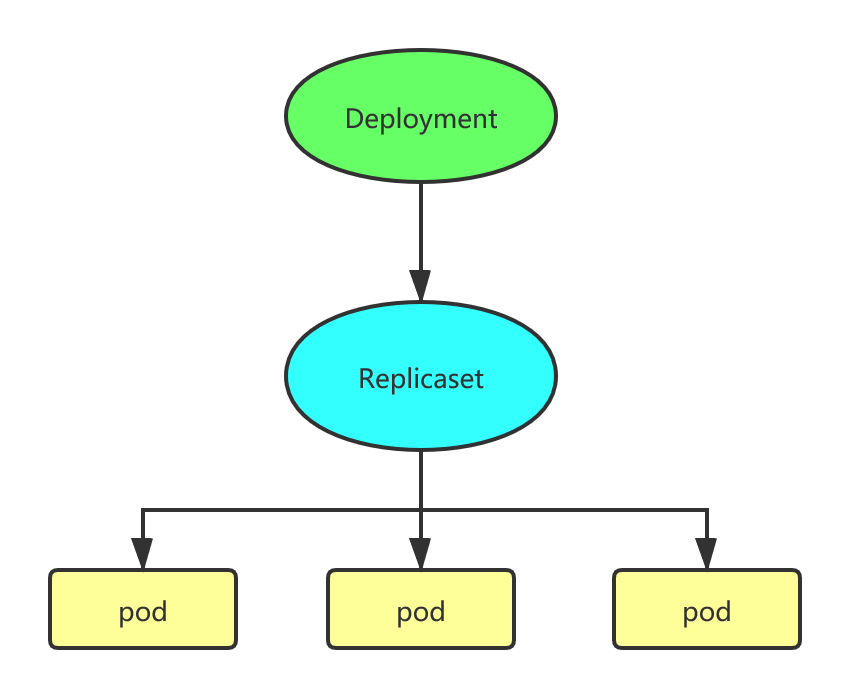

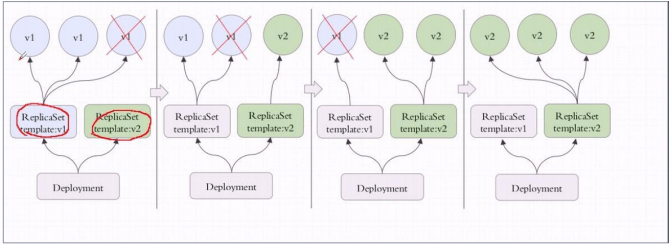

Deployment

Replicaset是Kubernetes中的副本控制器,管理Pod,使pod副本的数量始终维持在预设的个数。

Deployment是管理Replicaset和Pod的副本控制器,Deployment可以管理多个Replicaset,是比Replicaset更高级的控制器

也即是说在创建Deployment的时候,会自动创建Replicaset,由Replicaset再创建Pod,Deployment能对Pod扩容、缩容、滚动更新和回滚、维持Pod数量。

创建Deployment也可以使用yaml配置文件

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 ~]# cat deployment.yaml apiVersion: apps/v1 kind: Deployment metadata: name: my-nginx spec: selector: matchLabels: run: my-nginx replicas: 2 template: metadata: labels: run: my-nginx spec: containers: - name: my-nginx image: nginx ports: - containerPort: 80 ~]# kubectl apply -f deployment.yaml ~]# kubectl get deploy | grep my-nginx my-nginx 2 /2 2 2 2m52s ~]# kubectl get rs | grep my-nginx my-nginx-5b56ccd65f 2 2 2 3m26s ~]# kubectl get pods -l run=my-nginx NAME READY STATUS RESTARTS AGE my-nginx-5b56ccd65f-29w6d 1 /1 Running 0 102s my-nginx-5b56ccd65f-8dblk 1 /1 Running 0 102s

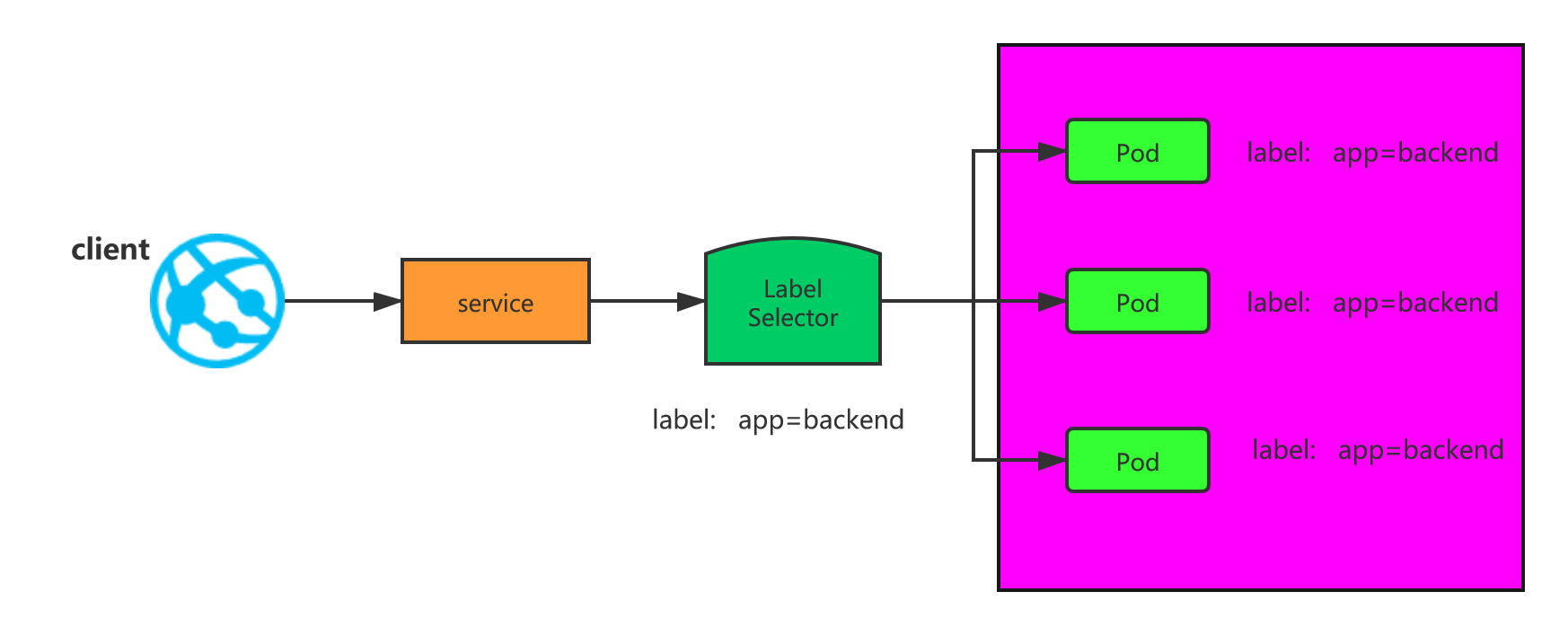

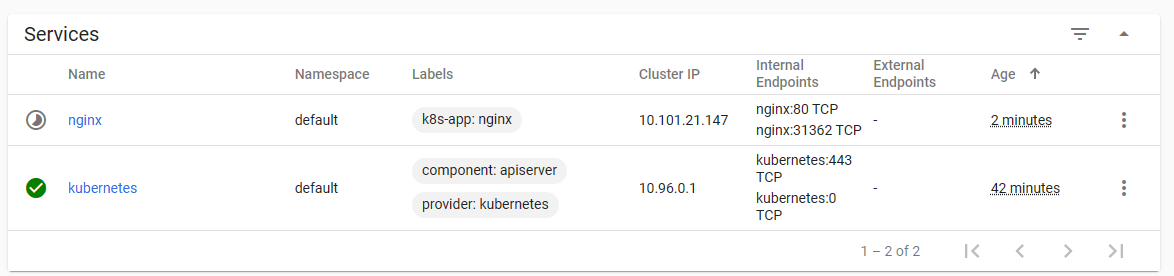

Service

在kubernetes中,Pod是有生命周期的,如果Pod重启IP很有可能会发生变化。如果我们的服务都是将Pod的IP地址写死,Pod的挂掉或者重启,和刚才重启的pod相关联的其他服务将会找不到它所关联的Pod

为了解决这个问题,在kubernetes中定义了service资源对象,Service 定义了一个服务访问的入口,客户端通过这个入口即可访问服务背后的应用集群实例,service是一组Pod的逻辑集合,这一组 Pod 能够被 Service 访问到,通常是通过 Label Selector实现的。

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 ~]# cat pod_test.yaml apiVersion: apps/v1 kind: Deployment metadata: name: my-nginx spec: selector: matchLabels: run: my-nginx replicas: 2 template: metadata: labels: run: my-nginx spec: containers: - name: my-nginx image: nginx ports: - containerPort: 80 ~]# cat service.yaml apiVersion: v1 kind: Service metadata: name: my-nginx labels: run: my-nginx spec: ports: - port: 80 protocol: TCP selector: run: my-nginx ~]# kubectl apply -f service.yaml ~]# kubectl get svc -l run=my-nginx NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE my-nginx ClusterIP 10.105 .104 .137 <none> 80 /TCP 12s ~]# curl 10.105 .104 .137

kubeadm安装高可用的k8s集群 k8s环境规划

centos7.6操作系统,4G/6CPU/100G,网络NAT,开启虚拟化

podSubnet(pod网段)10.244.0.0/16

k8s集群角色

ip

主机名

安装的组件

控制节点

192.168.1.180

master1

apiserver、controller-manager、scheduler、kubelet、etcd、docker、kube-proxy、keepalived、nginx、calico

控制节点

192.168.1.181

master2

apiserver、controller-manager、scheduler、kubelet、etcd、docker、kube-proxy、keepalived、nginx、calico

工作节点

192.168.1.182

node1

kubelet、kube-proxy、docker、calico、coredns

VIP

192.168.1.199

kubeadm 和二进制安装 k8s 适用场景分析

Kubeadm 和二进制都适合生产环境,在生产环境运行都很稳定,具体如何选择,可以根据实际项目进行评估。

kubeadm 是官方提供的开源工具,是一个开源项目,用于快速搭建 kubernetes 集群,目前是比较方便和推荐使用的。

kubeadm init 以及 kubeadm join 这两个命令可以快速创建 kubernetes 集群。

Kubeadm 初始化 k8s,所有的组件都是以 pod 形式运行的,具备故障自恢复能力

kubeadm 是工具,可以快速搭建集群,也就是相当于用程序脚本帮我们装好了集群,属于自动部署,简化部署操作,自动部署屏蔽了很多细节,使得对各个模块感知很少,如果对 k8s 架构组件理解不深的话,遇到问题比较难排查

kubeadm 适合需要经常部署 k8s,或者对自动化要求比较高的场景下使用。

二进制:在官网下载相关组件的二进制包,如果手动安装,对 kubernetes 理解也会更全面。

初始化实验环境

所有节点做相同操作

1 2 3 4 5 6 7 8 9 10 11 12 vim /etc/sysconfig/network-scripts/ifcfg-ens33 TYPE=Ethernet BOOTPROTO=static # static 表示静态 ip 地址 IPADDR=192.168.1.180 # ip 地址,需要跟自己电脑所在网段一致 NETMASK=255.255.255.0 # 子网掩码,需要跟自己电脑所在网段一致 GATEWAY=192.168.1.2 # 网关,在自己电脑打开 cmd,输入 ipconfig /all 可看到 DNS1=223.5.5.5 # DNS,在自己电脑打开 cmd,输入 ipconfig /all 可看到 NAME=ens33 # 网卡名字,跟 DEVICE 名字保持一致即可 DEVICE=ens33 # 网卡设备名,ip addr 可看到自己的这个网卡设备名 ONBOOT=yes # 开机自启动网络,必须是 yes service network restart

1 2 3 4 5 6 7 8 9 10 11 12 13 # 在 192.168.1.180 上执行 hostnamectl set-hostname master1 && bash # 在 192.168.40.181 上执行 hostnamectl set-hostname master2 && bash # 在 192.168.40.182 上执行 hostnamectl set-hostname node1 && bash # 配置主机 hosts 文件 192.168.1.180 master1 192.168.1.181 master2 192.168.1.182 node1

1 2 3 4 5 6 ssh-keygen for i in master1 master2 node1 do ssh-copy-id root@$i done

为什么要关闭 swap 交换分区?

Swap 是交换分区,如果机器内存不够,会使用 swap 分区,但是 swap 分区的性能较低,k8s 设计的时候为了能提升性能,默认是不允许使用交换分区的。Kubeadm 初始化的时候会检测 swap 是否关闭,如果没关闭,那就初始化失败。如果不想要关闭交换分区,安装 k8s 的时候可以指定–ignore-preflight-errors=Swap 来解决。

1 2 3 4 5 6 7 8 # 临时关闭 swapoff -a # 永久关闭:注释 swap 挂载,给 swap 这行开头加一下注释 vim /etc/fstab # /dev/mapper/centos-swap swap swap defaults 0 0 # 如果是克隆的虚拟机,需要删除 UUID

问题 1:sysctl 是做什么的?

在运行时配置内核参数

问题 2:为什么要执行 modprobe br_netfilter?

修改/etc/sysctl.d/k8s.conf 文件,增加如下三行参数:

解决方法:

问题 3:为什么开启 net.bridge.bridge-nf-call-iptables 内核参数?

在 centos 下安装 docker,执行 docker info 出现如下警告:

解决办法:

问题 4:为什么要开启 net.ipv4.ip_forward = 1 参数?

kubeadm 初始化 k8s 如果报错:

net.ipv4.ip_forward 是数据包转发:

1 2 3 4 5 6 7 8 9 10 modprobe br_netfilter echo "modprobe br_netfilter" >> /etc/profile cat > /etc/sysctl.d/k8s.conf <<EOF net.bridge.bridge-nf-call-ip6tables = 1 net.bridge.bridge-nf-call-iptables = 1 net.ipv4.ip_forward = 1 EOF sysctl -p /etc/sysctl.d/k8s.conf

1 2 3 systemctl stop firewalld systemctl disable firewalld systemctl status firewalld

1 2 3 4 5 6 7 8 9 10 11 12 # 修改 selinux 配置文件之后,重启机器,selinux 配置才能永久生效 sed -i 's/SELINUX=enforcing/SELINUX=disabled/g' /etc/selinux/config # 重启 reboot # 临时关闭 setenforce 0 # 显示 Disabled 说明 selinux 已经关闭 getenforce Disabled

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 # 备份基础repo源 mkdir /root/repo.bak cd /etc/yum.repos.d/ mv * /root/repo.bak/ # 拉取阿里云repo源 curl -o /etc/yum.repos.d/CentOS-Base.repo https://mirrors.aliyun.com/repo/Centos-7.repo # 配置国内阿里云 docker 的 repo 源 yum install yum-utils -y yum-config-manager --add-repo http://mirrors.aliyun.com/docker-ce/linux/centos/docker-ce.repo # 配置安装 k8s 组件需要的阿里云的 repo 源 vim /etc/yum.repos.d/kubernetes.repo [kubernetes] name=Kubernetes baseurl=https://mirrors.aliyun.com/kubernetes/yum/repos/kubernetes-el7-x86_64/ enabled=1 gpgcheck=0

1 2 3 4 5 6 7 8 9 10 11 12 # 安装 ntpdate 命令 yum install ntpdate -y # 跟网络时间做同步 ntpdate cn.pool.ntp.org # 把时间同步做成计划任务 crontab -e * */1 * * * /usr/sbin/ntpdate cn.pool.ntp.org # 重启 crond 服务 service crond restart

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 # 编写脚本开启模块 vim /etc/sysconfig/modules/ipvs.modules # !/bin/bash ipvs_modules="ip_vs ip_vs_lc ip_vs_wlc ip_vs_rr ip_vs_wrr ip_vs_lblc ip_vs_lblcr ip_vs_dh ip_vs_sh ip_vs_nq ip_vs_sed ip_vs_ftp nf_conntrack" for kernel_module in ${ipvs_modules}; do /sbin/modinfo -F filename ${kernel_module} > /dev/null 2>&1 if [ 0 -eq 0 ]; then /sbin/modprobe ${kernel_module} fi done # 执行脚本,查看模块是否开启 chmod 755 /etc/sysconfig/modules/ipvs.modules && bash /etc/sysconfig/modules/ipvs.modules && lsmod | grep ip_vs ip_vs_ftp 13079 0 nf_nat 26583 1 ip_vs_ftp ip_vs_sed 12519 0 ip_vs_nq 12516 0 ip_vs_sh 12688 0 ip_vs_dh 12688 0

问题 1:ipvs 是什么?

ipvs (IP Virtual Server) 实现了传输层负载均衡,也就是我们常说的 4 层 LAN 交换,作为 Linux内核的一部分。ipvs 运行在主机上,在真实服务器集群前充当负载均衡器。ipvs 可以将基于 TCP 和 UDP的服务请求转发到真实服务器上,并使真实服务器的服务在单个 IP 地址上显示为虚拟服务。

问题 2:ipvs 和 iptable 对比分析

kube-proxy 支持 iptables 和 ipvs 两种模式, 在 kubernetes v1.8 中引入了 ipvs 模式,在v1.9 中处于 beta 阶段,在 v1.11 中已经正式可用了。iptables 模式在 v1.1 中就添加支持了,从v1.2 版本开始 iptables 就是 kube-proxy 默认的操作模式,ipvs 和 iptables 都是基于 netfilter的,但是 ipvs 采用的是 hash 表,因此当 service 数量达到一定规模时,hash 查表的速度优势就会显现出来,从而提高 service 的服务性能。那么 ipvs 模式和 iptables 模式之间有哪些差异呢?

1、ipvs 为大型集群提供了更好的可扩展性和性能

1 yum install -y yum-utils device-mapper-persistent-data lvm2 wget net-tools nfs-utils lrzsz gcc gcc-c++ make cmake libxml2-devel openssl-devel curl curl-devel unzip sudo ntp libaio-devel wget vim ncurses-devel autoconf automake zlib-devel python-devel epel-release openssh-server socat ipvsadm conntrack ntpdate telnet

1 2 3 4 5 6 7 8 9 # 如果用 firewalld 不习惯,可以安装 iptables # 安装 iptables yum install iptables-services -y # 禁用 iptables service iptables stop && systemctl disable iptables # 清空防火墙规则 iptables -F

安装docker

所有节点做相同操作

1 2 3 yum install docker-ce-20.10.6 docker-ce-cli-20.10.6 containerd.io -y systemctl start docker && systemctl enable docker && systemctl status docker

1 2 3 4 5 6 7 8 9 10 11 vim /etc/docker/daemon.json { "registry-mirrors":["https://rsbud4vc.mirror.aliyuncs.com","https://registry.docker-cn.com","https://docker.mirrors.ustc.edu.cn","https://dockerhub.azk8s.cn","http://hub-mirror.c.163.com","http://qtid6917.mirror.aliyuncs.com","https://rncxm540.mirror.aliyuncs.com"], "exec-opts": ["native.cgroupdriver=systemd"] # "insecure-registries" : ["192.168.1.100" ]} # 修改 docker 文件驱动为 systemd,默认为 cgroupfs,kubelet 默认使用 systemd,两者必须一致才可以。 systemctl daemon-reload && systemctl restart docker systemctl status docker

安装初始化 k8s 需要的软件包

所有节点做相同操作

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 yum install -y kubelet-1.20.6 kubeadm-1.20.6 kubectl-1.20.6 systemctl enable kubelet && systemctl start kubelet # 可以看到 kubelet 状态不是 running 状态,这个是正常的,不用管,等 k8s 组件起来这个kubelet 就正常了。 systemctl status kubelet ● kubelet.service - kubelet: The Kubernetes Node Agent Loaded: loaded (/usr/lib/systemd/system/kubelet.service; enabled; vendor preset: disabled) Drop-In: /usr/lib/systemd/system/kubelet.service.d └─10-kubeadm.conf Active: activating (auto-restart) (Result: exit-code) since 日 2023-07-16 12:16:23 CST; 9s ago Docs: https://kubernetes.io/docs/ Process: 13693 ExecStart=/usr/bin/kubelet $KUBELET_KUBECONFIG_ARGS $KUBELET_CONFIG_ARGS $KUBELET_KUBEADM_ARGS $KUBELET_EXTRA_ARGS (code=exited, status=255) Main PID: 13693 (code=exited, status=255) # 注:每个软件包的作用 # Kubeadm: kubeadm 是一个工具,用来初始化 k8s 集群的 # kubelet: 安装在集群所有节点上,用于启动 Pod 的 # kubectl: 通过 kubectl 可以部署和管理应用,查看各种资源,创建、删除和更新各种组件

通过 keepalive+nginx 实现 k8s apiserver 节点高可用

在master1和master2上操作

1 2 # 在 master1 和 master2 上做 nginx 主备安装 yum install nginx keepalived nginx-mod-stream -y

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 vim /etc/nginx/nginx.conf user nginx; worker_processes auto; error_log /var/log/nginx/error.log; pid /run/nginx.pid; include /usr/share/nginx/modules/*.conf; events { worker_connections 1024; } # 四层负载均衡,为两台 Master apiserver 组件提供负载均衡 stream { log_format main '$remote_addr $upstream_addr - [$time_local] $status $upstream_bytes_sent'; access_log /var/log/nginx/k8s-access.log main; upstream k8s-apiserver { server 192.168.1.180:6443; # Master1 APISERVER IP:PORT server 192.168.1.181:6443; # Master2 APISERVER IP:PORT } server { listen 16443; # 由于 nginx 与 master 节点复用,这个监听端口不能是 6443,否则会冲突 proxy_pass k8s-apiserver; } } http { log_format main '$remote_addr - $remote_user [$time_local] "$request" ' '$status $body_bytes_sent "$http_referer" ' '"$http_user_agent" "$http_x_forwarded_for"'; access_log /var/log/nginx/access.log main; sendfile on; tcp_nopush on; tcp_nodelay on; keepalive_timeout 65; types_hash_max_size 2048; include /etc/nginx/mime.types; default_type application/octet-stream; server { listen 80 default_server; server_name _; location / { } } }

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 vim /etc/keepalived/keepalived.conf global_defs { notification_email { acassen@firewall.loc failover@firewall.loc sysadmin@firewall.loc } notification_email_from Alexandre.Cassen@firewall.loc smtp_server 127.0.0.1 smtp_connect_timeout 30 router_id NGINX_MASTER } vrrp_script check_nginx { script "/etc/keepalived/check_nginx.sh" } vrrp_instance VI_1 { state MASTER interface ens32 # 修改为实际网卡名 virtual_router_id 51 # VRRP 路由 ID 实例,每个实例是唯一的 priority 100 # 优先级,备服务器设置 90 advert_int 1 # 指定 VRRP 心跳包通告间隔时间,默认 1 秒 authentication { auth_type PASS auth_pass 1111 } # 虚拟 IP virtual_ipaddress { 192.168.1.199/24 } track_script { check_nginx } } # vrrp_script:指定检查 nginx 工作状态脚本(根据 nginx 状态判断是否故障转移) # virtual_ipaddress:虚拟 IP(VIP)

1 2 3 4 5 6 7 8 9 vim /etc/keepalived/check_nginx.sh # !/bin/bash count=$(ps -ef |grep nginx | grep sbin | egrep -cv "grep|$$") if [ "$count" -eq 0 ];then systemctl stop keepalived fi chmod +x /etc/keepalived/check_nginx.sh

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 vim /etc/keepalived/keepalived.conf global_defs { notification_email { acassen@firewall.loc failover@firewall.loc sysadmin@firewall.loc } notification_email_from Alexandre.Cassen@firewall.loc smtp_server 127.0.0.1 smtp_connect_timeout 30 router_id NGINX_MASTER } vrrp_script check_nginx { script "/etc/keepalived/check_nginx.sh" } vrrp_instance VI_1 { state BACKUP interface ens32 virtual_router_id 51 priority 90 advert_int 1 authentication { auth_type PASS auth_pass 1111 } # 虚拟 IP virtual_ipaddress { 192.168.1.199/24 } track_script { check_nginx } }

1 2 3 4 5 6 7 8 9 vim /etc/keepalived/check_nginx.sh # !/bin/bash count=$(ps -ef |grep nginx | grep sbin | egrep -cv "grep|$$") if [ "$count" -eq 0 ];then systemctl stop keepalived fi chmod +x /etc/keepalived/check_nginx.sh

1 2 3 4 5 6 7 systemctl daemon-reload systemctl start nginx && systemctl enable nginx systemctl start keepalived && systemctl enable keepalived systemctl status keepalived

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 [root@master1 ~]# ip addr 1: lo: <LOOPBACK,UP,LOWER_UP> mtu 65536 qdisc noqueue state UNKNOWN group default qlen 1000 link/loopback 00:00:00:00:00:00 brd 00:00:00:00:00:00 inet 127.0.0.1/8 scope host lo valid_lft forever preferred_lft forever inet6 ::1/128 scope host valid_lft forever preferred_lft forever 2: ens32: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc pfifo_fast state UP group default qlen 1000 link/ether 00:0c:29:3c:ad:b7 brd ff:ff:ff:ff:ff:ff inet 192.168.1.180/24 brd 192.168.1.255 scope global noprefixroute ens32 valid_lft forever preferred_lft forever inet 192.168.1.199/24 scope global secondary ens32 valid_lft forever preferred_lft forever inet6 fe80::f505:3807:9755:3839/64 scope link tentative noprefixroute dadfailed valid_lft forever preferred_lft forever inet6 fe80::559d:3360:2944:a1b1/64 scope link tentative noprefixroute dadfailed valid_lft forever preferred_lft forever inet6 fe80::a15a:e07:fa1e:4a60/64 scope link noprefixroute valid_lft forever preferred_lft forever 3: docker0: <NO-CARRIER,BROADCAST,MULTICAST,UP> mtu 1500 qdisc noqueue state DOWN group default link/ether 02:42:25:a7:a3:4c brd ff:ff:ff:ff:ff:ff inet 172.17.0.1/16 brd 172.17.255.255 scope global docker0 valid_lft forever preferred_lft forever

停掉 master1 上的 nginx。Vip 会漂移到 master2

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 [root@master1 ~]# systemctl stop nginx.service [root@master2 ~]# ip addr 1: lo: <LOOPBACK,UP,LOWER_UP> mtu 65536 qdisc noqueue state UNKNOWN group default qlen 1000 link/loopback 00:00:00:00:00:00 brd 00:00:00:00:00:00 inet 127.0.0.1/8 scope host lo valid_lft forever preferred_lft forever inet6 ::1/128 scope host valid_lft forever preferred_lft forever 2: ens32: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc pfifo_fast state UP group default qlen 1000 link/ether 00:0c:29:e0:93:9e brd ff:ff:ff:ff:ff:ff inet 192.168.1.181/24 brd 192.168.1.255 scope global noprefixroute ens32 valid_lft forever preferred_lft forever inet 192.168.1.199/24 scope global secondary ens32 valid_lft forever preferred_lft forever inet6 fe80::f505:3807:9755:3839/64 scope link tentative noprefixroute dadfailed valid_lft forever preferred_lft forever inet6 fe80::559d:3360:2944:a1b1/64 scope link noprefixroute valid_lft forever preferred_lft forever 3: docker0: <NO-CARRIER,BROADCAST,MULTICAST,UP> mtu 1500 qdisc noqueue state DOWN group default link/ether 02:42:69:d1:a0:c5 brd ff:ff:ff:ff:ff:ff inet 172.17.0.1/16 brd 172.17.255.255 scope global docker0 valid_lft forever preferred_lft forever

启动 xianchaomaster1 上的 nginx 和 keepalived,vip 又会漂移回来

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 [root@master1 ~]# systemctl daemon-reload [root@master1 ~]# systemctl start nginx.service [root@master1 ~]# systemctl start keepalived.service [root@master1 ~]# ip addr 1: lo: <LOOPBACK,UP,LOWER_UP> mtu 65536 qdisc noqueue state UNKNOWN group default qlen 1000 link/loopback 00:00:00:00:00:00 brd 00:00:00:00:00:00 inet 127.0.0.1/8 scope host lo valid_lft forever preferred_lft forever inet6 ::1/128 scope host valid_lft forever preferred_lft forever 2: ens32: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc pfifo_fast state UP group default qlen 1000 link/ether 00:0c:29:3c:ad:b7 brd ff:ff:ff:ff:ff:ff inet 192.168.1.180/24 brd 192.168.1.255 scope global noprefixroute ens32 valid_lft forever preferred_lft forever inet 192.168.1.199/24 scope global secondary ens32 valid_lft forever preferred_lft forever inet6 fe80::f505:3807:9755:3839/64 scope link tentative noprefixroute dadfailed valid_lft forever preferred_lft forever inet6 fe80::559d:3360:2944:a1b1/64 scope link tentative noprefixroute dadfailed valid_lft forever preferred_lft forever inet6 fe80::a15a:e07:fa1e:4a60/64 scope link noprefixroute valid_lft forever preferred_lft forever 3: docker0: <NO-CARRIER,BROADCAST,MULTICAST,UP> mtu 1500 qdisc noqueue state DOWN group default link/ether 02:42:25:a7:a3:4c brd ff:ff:ff:ff:ff:ff inet 172.17.0.1/16 brd 172.17.255.255 scope global docker0 valid_lft forever preferred_lft forever

kubeadm 初始化 k8s 集群

在master1上创建 kubeadm-config.yaml 文件

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 vim kubeadm-config.yaml apiVersion: kubeadm.k8s.io/v1beta2 kind: ClusterConfiguration kubernetesVersion: v1.20.6 controlPlaneEndpoint: 192.168 .1 .199 :16443 imageRepository: registry.aliyuncs.com/google_containers apiServer: certSANs: - 192.168 .1 .180 - 192.168 .1 .181 - 192.168 .1 .182 - 192.168 .1 .199 networking: podSubnet: 10.244 .0 .0 /16 serviceSubnet: 10.10 .0 .0 /16 --- apiVersion: kubeproxy.config.k8s.io/v1alpha1 kind: KubeProxyConfiguration mode: ipvs

把初始化 k8s 集群需要的离线镜像包上传到 master1、master2、node1机器上,手动解压:

1 2 3 docker load -i k8simage-1-20-6.tar.gz # 没有离线镜像包,会从阿里云拉取镜像

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 kubeadm init --config kubeadm-config.yaml --ignore-preflight-errors=SystemVerification # 显示如下,说明安装完成 Your Kubernetes control-plane has initialized successfully! To start using your cluster, you need to run the following as a regular user: mkdir -p $HOME/.kube sudo cp -i /etc/kubernetes/admin.conf $HOME/.kube/config sudo chown $(id -u):$(id -g) $HOME/.kube/config Alternatively, if you are the root user, you can run: export KUBECONFIG=/etc/kubernetes/admin.conf You should now deploy a pod network to the cluster. Run "kubectl apply -f [podnetwork].yaml" with one of the options listed at: https://kubernetes.io/docs/concepts/cluster-administration/addons/ You can now join any number of control-plane nodes by copying certificate authorities and service account keys on each node and then running the following as root: # 这里是把 master 节点加入集群的命令 kubeadm join 192.168.1.199:16443 --token 3yano8.s4yo3bdw8r71y2cw \ --discovery-token-ca-cert-hash sha256:4ba3577abc437bd0aa2a93072085ec94c7471824a3690328f03cb501e6e92830 \ --control-plane Then you can join any number of worker nodes by running the following on each as root: # 这里是把 node 节点加入集群的命令 kubeadm join 192.168.1.199:16443 --token 3yano8.s4yo3bdw8r71y2cw \ --discovery-token-ca-cert-hash sha256:4ba3577abc437bd0aa2a93072085ec94c7471824a3690328f03cb501e6e92830

相当于对 kubectl 进行授权,这样 kubectl 命令可以使用这个证书对 k8s 集群进行管理

1 2 3 4 5 mkdir -p $HOME/.kube sudo cp -i /etc/kubernetes/admin.conf $HOME/.kube/config sudo chown $(id -u):$(id -g) $HOME/.kube/config

扩容 k8s 集群-添加 master 节点

1 cd /root && mkdir -p /etc/kubernetes/pki/etcd &&mkdir -p ~/.kube/

把 master1 节点的证书拷贝到 master2 上

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 scp /etc/kubernetes/pki/ca.crt master2:/etc/kubernetes/pki/ scp /etc/kubernetes/pki/ca.key master2:/etc/kubernetes/pki/ scp /etc/kubernetes/pki/sa.key master2:/etc/kubernetes/pki/ scp /etc/kubernetes/pki/sa.pub master2:/etc/kubernetes/pki/ scp /etc/kubernetes/pki/front-proxy-ca.crt master2:/etc/kubernetes/pki/ scp /etc/kubernetes/pki/front-proxy-ca.key master2:/etc/kubernetes/pki/ scp /etc/kubernetes/pki/etcd/ca.crt master2:/etc/kubernetes/pki/etcd/ scp /etc/kubernetes/pki/etcd/ca.key master2:/etc/kubernetes/pki/etcd/

在master1上查看加入命令

1 2 3 4 kubeadm token create --print-join-command kubeadm join 192.168.1.199:16443 --token b6s893.vo2d43b2488tif6c \ --discovery-token-ca-cert-hash sha256:4ba3577abc437bd0aa2a93072085ec94c7471824a3690328f03cb501e6e92830

master2执行命令

1 2 3 4 5 6 7 8 kubeadm join 192.168.1.199:16443 --token b6s893.vo2d43b2488tif6c \ --discovery-token-ca-cert-hash sha256:4ba3577abc437bd0aa2a93072085ec94c7471824a3690328f03cb501e6e92830 \ --control-plane --ignore-preflight-errors=SystemVerification mkdir -p $HOME/.kube sudo cp -i /etc/kubernetes/admin.conf $HOME/.kube/config sudo chown $(id -u):$(id -g) $HOME/.kube/config

1 2 3 4 5 6 # 可以看到 master2 已经加入到集群了 kubectl get nodes NAME STATUS ROLES AGE VERSION master1 NotReady control-plane,master 33m v1.20.6 master2 NotReady control-plane,master 80s v1.20.6

扩容 k8s 集群-添加 node 节点

1 2 3 4 kubeadm token create --print-join-command kubeadm join 192.168.1.199:16443 --token flsons.7c66kxcihkjpgnly \ --discovery-token-ca-cert-hash sha256:4ba3577abc437bd0aa2a93072085ec94c7471824a3690328f03cb501e6e92830

1 2 3 kubeadm join 192.168.1.199:16443 --token flsons.7c66kxcihkjpgnly \ --discovery-token-ca-cert-hash sha256:4ba3577abc437bd0aa2a93072085ec94c7471824a3690328f03cb501e6e92830 \ --ignore-preflight-errors=SystemVerification

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 kubectl get nodes NAME STATUS ROLES AGE VERSION master1 NotReady control-plane,master 64m v1.20.6 master2 NotReady control-plane,master 31m v1.20.6 node1 NotReady <none> 42s v1.20.6 # 可以看到 node1 的 ROLES 角色为空,<none>就表示这个节点是工作节点。 # 可以把 node1 的 ROLES 变成 work kubectl label node node1 node-role.kubernetes.io/worker=worker kubectl get nodes NAME STATUS ROLES AGE VERSION master1 NotReady control-plane,master 65m v1.20.6 master2 NotReady control-plane,master 33m v1.20.6 node1 NotReady worker 2m18s v1.20.6 kubectl get pods -n kube-system NAME READY STATUS RESTARTS AGE coredns-7f89b7bc75-2ht5z 0/1 Pending 0 66m coredns-7f89b7bc75-xv9mv 0/1 Pending 0 66m etcd-master1 1/1 Running 0 66m etcd-master2 1/1 Running 0 33m kube-apiserver-master1 1/1 Running 1 66m kube-apiserver-master2 1/1 Running 0 33m kube-controller-manager-master1 1/1 Running 1 66m kube-controller-manager-master2 1/1 Running 0 33m kube-proxy-q9dq7 1/1 Running 0 2m48s kube-proxy-w664w 1/1 Running 0 66m kube-proxy-wkqdv 1/1 Running 0 33m kube-scheduler-master1 1/1 Running 1 66m kube-scheduler-master2 1/1 Running 0 33m # coredns-7f89b7bc75-2ht5z 是 pending 状态,这是因为还没有安装网络插件,等到下面安装好网络插件之后这个 cordns 就会变成 running 了

安装 kubernetes 网络组件-Calico

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 # 在master1上安装 wget https://docs.projectcalico.org/manifests/calico.yaml # 版本可能不同会有报错 # apiVersion: policy/v1 >改>为> policy/v1beta1 # kind: PodDisruptionBudget # 有镜像包的话,三台虚拟机上都需要docker load # 有自己的镜像站让其他节点加入就行 kubectl apply -f calico.yaml kubectl get pods -n kube-system NAME READY STATUS RESTARTS AGE calico-kube-controllers-6949477b58-tf9dm 1/1 Running 0 27s calico-node-bmr42 1/1 Running 0 27s calico-node-qfkwj 1/1 Running 0 27s calico-node-tqb7c 1/1 Running 0 27s coredns-7f89b7bc75-2ht5z 1/1 Running 0 151m coredns-7f89b7bc75-xv9mv 1/1 Running 0 151m etcd-master1 1/1 Running 0 151m etcd-master2 1/1 Running 0 119m kube-apiserver-master1 1/1 Running 1 151m kube-apiserver-master2 1/1 Running 0 119m kube-controller-manager-master1 1/1 Running 1 151m kube-controller-manager-master2 1/1 Running 0 119m kube-proxy-q9dq7 1/1 Running 0 88m kube-proxy-w664w 1/1 Running 0 151m kube-proxy-wkqdv 1/1 Running 0 119m kube-scheduler-master1 1/1 Running 1 151m kube-scheduler-master2 1/1 Running 0 119m # coredns-这个 pod 现在是 running 状态,运行正常

1 2 3 4 5 6 7 # STATUS 状态是 Ready,说明 k8s 集群正常运行了 kubectl get nodes NAME STATUS ROLES AGE VERSION master1 Ready control-plane,master 153m v1.20.6 master2 Ready control-plane,master 120m v1.20.6 node1 Ready worker 89m v1.20.6

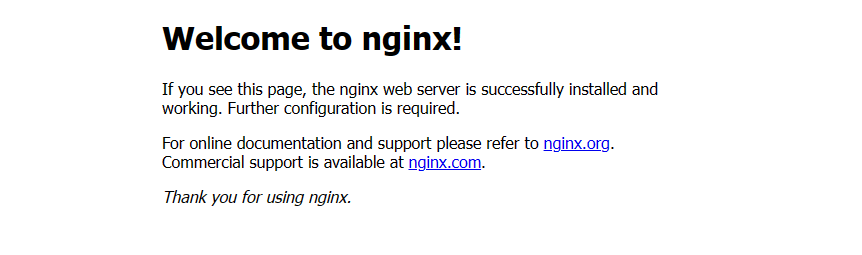

测试在 k8s 创建 pod 是否可以正常访问网络

1 2 3 4 5 6 7 8 kubectl run busybox --image busybox:1.28 --restart=Never --rm -it -- sh / # ping baidu.com PING baidu.com (39.156.66.10): 56 data bytes 64 bytes from 39.156.66.10: seq=0 ttl=127 time=18.707 ms 64 bytes from 39.156.66.10: seq=1 ttl=127 time=18.246 ms # 通过上面可以看到能访问网络,说明 calico 网络插件已经被正常安装了

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 [root@master1 ~]# cat tomcat.yaml apiVersion: v1 #pod属于k8s核心组v1 kind: Pod #创建的是一个Pod资源 metadata: #元数据 name: demo-pod #pod名字 namespace: default #pod所属的名称空间 labels: app: myapp #pod具有的标签 env: dev #pod具有的标签 spec: containers: #定义一个容器,容器是对象列表,下面可以有多个name - name: tomcat-pod-java #容器的名字 ports: - containerPort: 8080 image: tomcat:8.5-jre8-alpine #容器使用的镜像 imagePullPolicy: IfNotPresent [root@master1 ~]# cat tomcat-service.yaml apiVersion: v1 kind: Service metadata: name: tomcat spec: type: NodePort ports: - port: 8080 nodePort: 30080 selector: app: myapp env: dev [root@master1 ~]# kubectl apply -f tomcat.yaml [root@master1 ~]# kubectl get pods -o wide NAME READY STATUS RESTARTS AGE IP NODE NOMINATED NODE READINESS GATES demo-pod 1/1 Running 0 7m44s 10.244.166.133 node1 <none> <none> [root@master1 ~]# curl http://10.244.166.133:8080 -I HTTP/1.1 200 # 状态码 200 为正常 Content-Type: text/html;charset=UTF-8 Transfer-Encoding: chunked Date: Sun, 16 Jul 2023 10:32:55 GMT [root@master1 ~]# kubectl apply -f tomcat-service.yaml [root@master1 ~]# kubectl get svc NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE kubernetes ClusterIP 10.10.0.1 <none> 443/TCP 160m tomcat NodePort 10.10.24.186 <none> 8080:30080/TCP 34s # 浏览器访问master节点的IP:30080,即可打开tomcat

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 kubectl run busybox --image busybox:1.28 --restart=Never --rm -it busybox -- sh / # nslookup kubernetes.default.svc.cluster.local Server: 10.10.0.10 Address 1: 10.10.0.10 kube-dns.kube-system.svc.cluster.local Name: kubernetes.default.svc.cluster.local Address 1: 10.10.0.1 kubernetes.default.svc.cluster.local / # nslookup tomcat.default.svc.cluster.local Server: 10.10.0.10 Address 1: 10.10.0.10 kube-dns.kube-system.svc.cluster.local Name: tomcat.default.svc.cluster.local Address 1: 10.10.24.186 tomcat.default.svc.cluster.local # 10.10.0.10 就是我们 coreDNS 的 clusterIP,说明 coreDNS 配置好了。 [root@master1 ~]# kubectl get svc -n kube-system NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE kube-dns ClusterIP 10.10.0.10 <none> 53/UDP,53/TCP,9153/TCP 3h2m # 解析内部 Service 的名称,是通过 coreDNS 去解析的。 # 10.10.24.186 是创建的 tomcat 的 service ip [root@master1 ~]# kubectl get svc NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE kubernetes ClusterIP 10.10.0.1 <none> 443/TCP 3h3m tomcat NodePort 10.10.24.186 <none> 8080:30080/TCP 22m # 注意:busybox 要用指定的 1.28 版本,不能用最新版本,最新版本,nslookup 会解析不到 dns 和 ip

二进制安装多master的k8s集群 k8s环境规划

centos7.6操作系统,4G/4CPU/100G,网络NAT,开启虚拟化

podSubnet(pod网段)10.0.0.0/16

k8s集群角色

ip

主机名

安装的组件

控制节点

192.168.1.180

master1

apiserver、controller-manager、scheduler、etcd、docker、keepalived、nginx

控制节点

192.168.1.181

master2

apiserver、controller-manager、scheduler、etcd、docker、keepalived、nginx

控制节点

192.168.1.182

master3

apiserver、controller-manager、scheduler、etcd、docker

工作节点

192.168.1.183

node1

kubelet、kube-proxy、docker、calico、coredns

VIP

192.168.1.199

初始化

所有主机做以下操作

1 2 3 4 echo "192.168.1.180 master1 192.168.1.181 master2 192.168.1.182 master3 192.168.1.183 node1" >> /etc/hosts

1 2 3 ssh-keygen for i in master1 master2 master3 node1;do ssh-copy-id root@$i;done

1 systemctl disable --now firewalld

1 2 3 4 5 6 7 sed -i 's/SELINUX=enforcing/SELINUX=disabled/g' /etc/selinux/config # 重启生效 reboot # 显示 Disabled 说明 selinux 已经关闭 getenforce

1 2 3 4 5 6 7 8 # 临时关闭 swapoff -a # 永久关闭:注释 swap 挂载,给 swap 这行开头加一下注释 vim /etc/fstab # /dev/mapper/centos-swap swap swap defaults 0 0 # 如果是克隆的虚拟机,需要删除 UUID

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 # 加载 br_netfilter 模块 modprobe br_netfilter # 验证模块是否加载成功: lsmod |grep br_netfilter # 修改内核参数 cat > /etc/sysctl.d/k8s.conf <<EOF net.bridge.bridge-nf-call-ip6tables = 1 net.bridge.bridge-nf-call-iptables = 1 net.ipv4.ip_forward = 1 EOF # 使刚才修改的内核参数生效 sysctl -p /etc/sysctl.d/k8s.conf

1 2 3 4 5 6 7 8 9 10 11 12 # 备份基础repo源 mkdir /root/repo.bak cd /etc/yum.repos.d/ mv * /root/repo.bak/ # 拉取阿里云repo源 curl -o /etc/yum.repos.d/CentOS-Base.repo https://mirrors.aliyun.com/repo/Centos-7.repo # 配置国内阿里云 docker 的 repo 源 yum install yum-utils -y yum-config-manager --add-repo http://mirrors.aliyun.com/docker-ce/linux/centos/docker-ce.repo

1 2 3 4 5 6 7 8 9 10 11 12 # 安装 ntpdate 命令, yum install ntpdate -y # 跟网络源做同步 ntpdate cn.pool.ntp.org # 把时间同步做成计划任务 crontab -e * */1 * * * /usr/sbin/ntpdate cn.pool.ntp.org # 重启 crond 服务 service crond restart

1 2 3 4 5 6 7 8 # 安装 iptables yum install iptables-services -y # 禁用 iptables service iptables stop && systemctl disable iptables # 清空防火墙规则 iptables -F

不开启 ipvs 将会使用 iptables 进行数据包转发,但是效率低,所以官网推荐需要开通 ipvs。

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 # 编写脚本开启模块 vim /etc/sysconfig/modules/ipvs.modules # !/bin/bash ipvs_modules="ip_vs ip_vs_lc ip_vs_wlc ip_vs_rr ip_vs_wrr ip_vs_lblc ip_vs_lblcr ip_vs_dh ip_vs_sh ip_vs_nq ip_vs_sed ip_vs_ftp nf_conntrack" for kernel_module in ${ipvs_modules}; do /sbin/modinfo -F filename ${kernel_module} > /dev/null 2>&1 if [ 0 -eq 0 ]; then /sbin/modprobe ${kernel_module} fi done # 执行脚本,查看模块是否开启 chmod 755 /etc/sysconfig/modules/ipvs.modules && bash /etc/sysconfig/modules/ipvs.modules && lsmod | grep ip_vs ip_vs_ftp 13079 0 nf_nat 26583 1 ip_vs_ftp ip_vs_sed 12519 0 ip_vs_nq 12516 0 ip_vs_sh 12688 0 ip_vs_dh 12688 0

1 yum install -y yum-utils device-mapper-persistent-data lvm2 wget net-tools nfs-utils lrzsz gcc gcc-c++ make cmake libxml2-devel openssl-devel curl curl-devel unzip sudo ntp libaio-devel wget vim ncurses-devel autoconf automake zlib-devel python-devel epel-release openssh-server socat ipvsadm conntrack ntpdate telnet rsync

1 2 3 yum install docker-ce docker-ce-cli containerd.io -y systemctl start docker && systemctl enable docker.service && systemctl status docker

1 2 3 4 5 6 7 8 9 10 11 tee /etc/docker/daemon.json << 'EOF' { "registry-mirrors":["https://rsbud4vc.mirror.aliyuncs.com","https://registry.docker-cn.com","https://docker.mirrors.ustc.edu.cn","https://dockerhub.azk8s.cn","http://hub-mirror.c.163.com","http://qtid6917.mirror.aliyuncs.com","https://rncxm540.mirror.aliyuncs.com"], "exec-opts": ["native.cgroupdriver=systemd"] # "insecure-registries" : ["192.168.1.100" ]} EOF systemctl daemon-reload systemctl restart docker systemctl status docker

搭建etcd集群

1 2 3 4 5 [root@master1 ~]# mkdir -p /etc/etcd/ssl [root@master2 ~]# mkdir -p /etc/etcd/ssl [root@master3 ~]# mkdir -p /etc/etcd/ssl

先在master1上操作,后面会拷贝给其他master主机

1 2 3 4 5 6 7 8 9 10 11 12 13 14 [root@master1 ~]# mkdir /data/work -p [root@master1 ~]# cd /data/work/ # cfssl-certinfo_linux-amd64 、cfssljson_linux-amd64 、cfssl_linux-amd64 上传到/data/work/目录下 [root@master1 work]# ls cfssl-certinfo_linux-amd64 cfssljson_linux-amd64 cfssl_linux-amd64 [root@master1 work]# chmod +x * [root@master1 work]# mv cfssl_linux-amd64 /usr/local/bin/cfssl [root@master1 work]# mv cfssljson_linux-amd64 /usr/local/bin/cfssljson [root@master1 work]# mv cfssl-certinfo_linux-amd64 /usr/local/bin/cfssl-certinfo

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 # 生成ca证书请求文件 [root@master1 work]# cat ca-csr.json { "CN": "kubernetes", "key": { "algo": "rsa", "size": 2048 }, "names": [ { "C": "CN", "ST": "Hubei", "L": "Wuhan", "O": "k8s", "OU": "system" } ], "ca": { "expiry": "87600h" } } # CN:Common Name(公用名称),kube-apiserver 从证书中提取该字段作为请求的用户名 (User Name);浏览器使用该字段验证网站是否合法;对于 SSL 证书,一般为网站域名;而对于代码签名证书则为申请单位名称;而对于客户端证书则为证书申请者的姓名。 # O:Organization(单位名称),kube-apiserver 从证书中提取该字段作为请求用户所属的组 (Group);对于 SSL 证书,一般为网站域名;而对于代码签名证书则为申请单位名称;而对于客户端单位证书则为证书申请者所在单位名称。 # L 字段:所在城市 # S 字段:所在省份 # C 字段:只能是国家字母缩写,如中国:CN [root@master1 work]# cfssl gencert -initca ca-csr.json | cfssljson -bare ca 2023/07/17 18:24:49 [INFO] generating a new CA key and certificate from CSR 2023/07/17 18:24:49 [INFO] generate received request 2023/07/17 18:24:49 [INFO] received CSR 2023/07/17 18:24:49 [INFO] generating key: rsa-2048 2023/07/17 18:24:49 [INFO] encoded CSR 2023/07/17 18:24:49 [INFO] signed certificate with serial number 217844315801648044942786609438022401383793351285 # 生成ca证书文件 [root@master1 work]# cat ca-config.json { "signing": { "default": { "expiry": "87600h" }, "profiles": { "kubernetes": { "usages": [ "signing", "key encipherment", "server auth", "client auth" ], "expiry": "87600h" } } } }

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 [root@master1 work]# cat etcd-csr.json { "CN": "etcd", "hosts": [ "127.0.0.1", "192.168.1.180", "192.168.1.181", "192.168.1.182", "192.168.1.199" ], "key": { "algo": "rsa", "size": 2048 }, "names": [{ "C": "CN", "ST": "Hubei", "L": "Wuhan", "O": "k8s", "OU": "system" }] } [root@master1 work]# cfssl gencert -ca=ca.pem -ca-key=ca-key.pem -config=ca-config.json -profile=kubernetes etcd-csr.json | cfssljson -bare etcd 2023/07/17 18:28:48 [INFO] generate received request 2023/07/17 18:28:48 [INFO] received CSR 2023/07/17 18:28:48 [INFO] generating key: rsa-2048 2023/07/17 18:28:48 [INFO] encoded CSR 2023/07/17 18:28:48 [INFO] signed certificate with serial number 454088009324202770940629185352283532986074407108 2023/07/17 18:28:48 [WARNING] This certificate lacks a "hosts" field. This makes it unsuitable for websites. For more information see the Baseline Requirements for the Issuance and Management of Publicly-Trusted Certificates, v.1.1.6, from the CA/Browser Forum (https://cabforum.org); specifically, section 10.2.3 ("Information Requirements"). [root@master1 work]# ls etcd*.pem etcd-key.pem etcd.pem

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 63 64 65 66 67 68 69 70 71 72 73 74 75 76 77 # 把 etcd-v3.4.13-linux-amd64.tar.gz 上传到/data/work 目录下 [root@master1 work]# tar xf etcd-v3.4.13-linux-amd64.tar.gz [root@master1 work]# cp -p etcd-v3.4.13-linux-amd64/etcd* /usr/local/bin/ [root@master1 work]# scp -r etcd-v3.4.13-linux-amd64/etcd* master2:/usr/local/bin/ [root@master1 work]# scp -r etcd-v3.4.13-linux-amd64/etcd* master3:/usr/local/bin/ # 创建配置文件 [root@master1 work]# cat etcd.conf # [Member] ETCD_NAME="etcd1" ETCD_DATA_DIR="/var/lib/etcd/default.etcd" ETCD_LISTEN_PEER_URLS="https://192.168.1.180:2380" ETCD_LISTEN_CLIENT_URLS="https://192.168.1.180:2379,http://127.0.0.1:2379" # [Clustering] ETCD_INITIAL_ADVERTISE_PEER_URLS="https://192.168.1.180:2380" ETCD_ADVERTISE_CLIENT_URLS="https://192.168.1.180:2379" ETCD_INITIAL_CLUSTER="etcd1=https://192.168.1.180:2380,etcd2=https://192.168.1.181:2380,etcd3=https://192.168.1.182:2380" ETCD_INITIAL_CLUSTER_TOKEN="etcd-cluster" ETCD_INITIAL_CLUSTER_STATE="new" # ETCD_NAME:节点名称,集群中唯一 # ETCD_DATA_DIR:数据目录 # ETCD_LISTEN_PEER_URLS:集群通信监听地址 # ETCD_LISTEN_CLIENT_URLS:客户端访问监听地址 # ETCD_INITIAL_ADVERTISE_PEER_URLS:集群通告地址 # ETCD_ADVERTISE_CLIENT_URLS:客户端通告地址 # ETCD_INITIAL_CLUSTER:集群节点地址 # ETCD_INITIAL_CLUSTER_TOKEN:集群 Token # ETCD_INITIAL_CLUSTER_STATE:加入集群的当前状态,new 是新集群,existing 表示加入已有集群 # 创建启动服务文件 [root@master1 work]# cat etcd.service [Unit] Description=Etcd Server After=network.target After=network-online.target Wants=network-online.target [Service] Type=notify EnvironmentFile=-/etc/etcd/etcd.conf WorkingDirectory=/var/lib/etcd/ ExecStart=/usr/local/bin/etcd \ --cert-file=/etc/etcd/ssl/etcd.pem \ --key-file=/etc/etcd/ssl/etcd-key.pem \ --trusted-ca-file=/etc/etcd/ssl/ca.pem \ --peer-cert-file=/etc/etcd/ssl/etcd.pem \ --peer-key-file=/etc/etcd/ssl/etcd-key.pem \ --peer-trusted-ca-file=/etc/etcd/ssl/ca.pem \ --peer-client-cert-auth \ --client-cert-auth Restart=on-failure RestartSec=5 LimitNOFILE=65536 [Install] WantedBy=multi-user.target [root@master1 work]# cp ca*.pem /etc/etcd/ssl/ [root@master1 work]# cp etcd*.pem /etc/etcd/ssl/ [root@master1 work]# cp etcd.conf /etc/etcd/ [root@master1 work]# cp etcd.service /usr/lib/systemd/system/ [root@master1 work]# for i in master2 master3;do rsync -vaz etcd.conf $i:/etc/etcd/;done [root@master1 work]# for i in master2 master3;do rsync -vaz ca*.pem $i:/etc/etcd/ssl/;done [root@master1 work]# for i in master2 master3;do rsync -vaz etcd*.pem $i:/etc/etcd/ssl/;done [root@master1 work]# for i in master2 master3;do rsync -vaz etcd.service $i:/usr/lib/systemd/system/;done

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 [root@master1 work]# mkdir -p /var/lib/etcd/default.etcd [root@master2 ~]# mkdir -p /var/lib/etcd/default.etcd [root@master3 ~]# mkdir -p /var/lib/etcd/default.etcd [root@master2 ~]# vim /etc/etcd/etcd.conf # [Member] ETCD_NAME="etcd2" ETCD_DATA_DIR="/var/lib/etcd/default.etcd" ETCD_LISTEN_PEER_URLS="https://192.168.1.181:2380" ETCD_LISTEN_CLIENT_URLS="https://192.168.1.181:2379,http://127.0.0.1:2379" # [Clustering] ETCD_INITIAL_ADVERTISE_PEER_URLS="https://192.168.1.181:2380" ETCD_ADVERTISE_CLIENT_URLS="https://192.168.1.181:2379" ETCD_INITIAL_CLUSTER="etcd1=https://192.168.1.180:2380,etcd2=https://192.168.1.181:2380,etcd3=https://192.168.1.182:2380" ETCD_INITIAL_CLUSTER_TOKEN="etcd-cluster" ETCD_INITIAL_CLUSTER_STATE="new" [root@master3 ~]# vim /etc/etcd/etcd.conf # [Member] ETCD_NAME="etcd3" ETCD_DATA_DIR="/var/lib/etcd/default.etcd" ETCD_LISTEN_PEER_URLS="https://192.168.1.182:2380" ETCD_LISTEN_CLIENT_URLS="https://192.168.1.182:2379,http://127.0.0.1:2379" # [Clustering] ETCD_INITIAL_ADVERTISE_PEER_URLS="https://192.168.1.182:2380" ETCD_ADVERTISE_CLIENT_URLS="https://192.168.1.182:2379" ETCD_INITIAL_CLUSTER="etcd1=https://192.168.1.180:2380,etcd2=https://192.168.1.181:2380,etcd3=https://192.168.1.182:2380" ETCD_INITIAL_CLUSTER_TOKEN="etcd-cluster" ETCD_INITIAL_CLUSTER_STATE="new" [root@master1 ~]# systemctl daemon-reload && systemctl enable etcd.service && systemctl start etcd.service # 启动 etcd 的时候,先启动 master1 的 etcd 服务,会一直卡住在启动的状态,然后接着再启动 master2 的 etcd,这样 master1 这个节点 etcd 才会正常起来 [root@master2 ~]# systemctl daemon-reload && systemctl enable etcd.service && systemctl start etcd.service [root@master3 ~]# systemctl daemon-reload && systemctl enable etcd.service && systemctl start etcd.service

1 2 3 4 5 6 7 8 9 10 [root@master1 ~]# ETCDCTL_API=3 [root@master1 ~]# /usr/local/bin/etcdctl --write-out=table --cacert=/etc/etcd/ssl/ca.pem --cert=/etc/etcd/ssl/etcd.pem --key=/etc/etcd/ssl/etcd-key.pem --endpoints=https://192.168.1.180:2379,https://192.168.1.181:2379,https://192.168.1.182:2379 endpoint health +----------------------------+--------+-------------+-------+ | ENDPOINT | HEALTH | TOOK | ERROR | +----------------------------+--------+-------------+-------+ | https://192.168.1.180:2379 | true | 10.004032ms | | | https://192.168.1.181:2379 | true | 14.682589ms | | | https://192.168.1.182:2379 | true | 14.800295ms | | +----------------------------+--------+-------------+-------+

安装kubernetes组件 下载安装包

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 # 把 kubernetes-server-linux-amd64.tar.gz 上传到 xianchaomaster1 上的/data/work 目录下 [root@master1 work]# tar xf kubernetes-server-linux-amd64.tar.gz [root@master1 work]# cd kubernetes/server/bin/ [root@master1 bin]# cp kube-apiserver kube-controller-manager kube-scheduler kubectl /usr/local/bin/ [root@master1 bin]# rsync -vaz kube-apiserver kube-controller-manager kube-scheduler kubectl master2:/usr/local/bin/ [root@master1 bin]# rsync -vaz kube-apiserver kube-controller-manager kube-scheduler kubectl master3:/usr/local/bin/ [root@master1 bin]# scp kubelet kube-proxy node1:/usr/local/bin/ [root@master1 bin]# cd /data/work/ [root@master1 work]# mkdir -p /etc/kubernetes/ssl [root@master1 work]# mkdir /var/log/kubernetes

部署apiserver组件

启动 TLS Bootstrapping 机制

Master apiserver 启用 TLS 认证后,每个节点的 kubelet 组件都要使用由 apiserver 使用的 CA 签发的有效证书才能与 apiserver 通讯,当 Node 节点很多时,这种客户端证书颁发需要大量工作,同样也会增加集群扩展复杂度。

为了简化流程,Kubernetes 引入了 TLS bootstraping 机制来自动颁发客户端证书,kubelet 会以一个低权限用户自动向 apiserver 申请证书,kubelet 的证书由 apiserver 动态签署。

Bootstrap 是很多系统中都存在的程序,比如 Linux 的 bootstrap,bootstrap 一般都是作为预先配置在开启或者系统启动的时候加载,这可以用来生成一个指定环境。Kubernetes 的 kubelet 在启动时同样可以加载一个这样的配置文件,这个文件的内容类似如下形式:

1 2 3 4 5 6 7 8 9 10 11 12 13 apiVersion: v1 clusters: null contexts: - context: cluster: kubernetes user: kubelet-bootstra name: default current-context: default kind: Config preferences: {}users: - name: kubelet-bootstrap user: {}

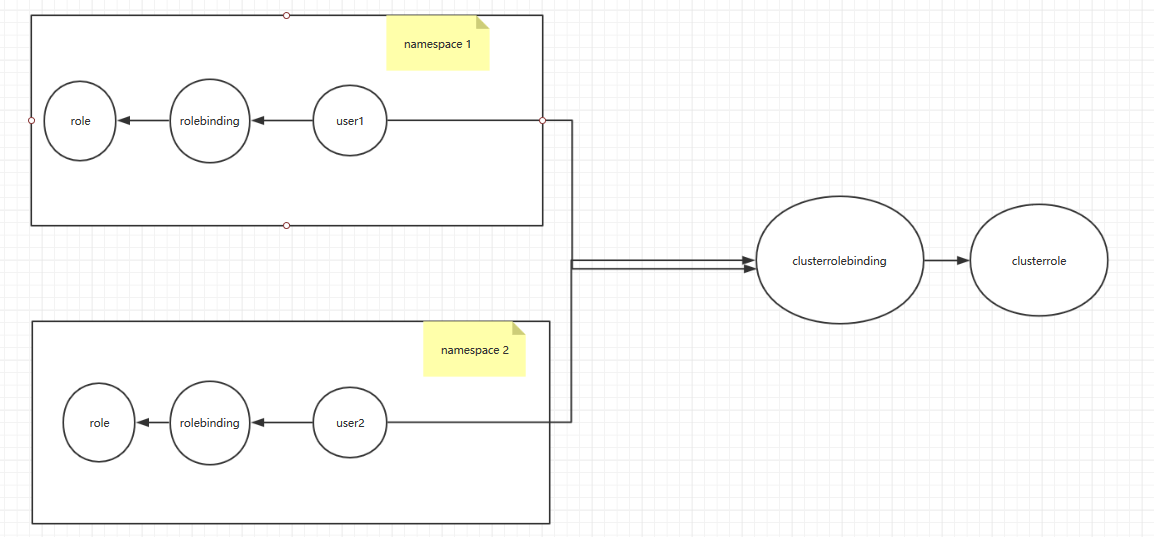

TLS bootstrapping 具体引导过程

1.TLS 作用

2.RBAC 作用

以上说明:第一,想要与 apiserver 通讯就必须采用由 apiserver CA 签发的证书,这样才能形成信任关系,建立 TLS 连接;第二,可以通过证书的 CN、O 字段来提供 RBAC 所需的用户与用户组。

kubelet 首次启动流程

TLS bootstrapping 功能是让 kubelet 组件去 apiserver 申请证书,然后用于连接 apiserver;那么第一次启动时没有证书如何连接 apiserver ?

在 apiserver 配置中指定了一个 token.csv 文件,该文件中是一个预设的用户配置;同时该用户的 Token 和 由 apiserver 的 CA 签发的用户被写入了 kubelet 所使用的 bootstrap.kubeconfig 配置文件中;这样在首次请求时,kubelet 使用 bootstrap.kubeconfig 中被 apiserver CA 签发证书时信任的用户来与 apiserver 建立TLS 通讯,使用 bootstrap.kubeconfig 中的用户 Token 来向 apiserver 声明自己的 RBAC 授权身份.

token.csv 格式:

3940fd7fbb391d1b4d861ad17a1f0613,kubelet-bootstrap,10001,”system:kubelet-bootstrap”

首次启动时,可能与遇到 kubelet 报 401 无权访问 apiserver 的错误;这是因为在默认情况下,kubelet 通过 bootstrap.kubeconfig 中的预设用户 Token 声明了自己的身份,然后创建CSR 请求;但是不要忘记这个用户在我们不处理的情况下他没任何权限的,包括创建 CSR 请求;所以需要创建一个 ClusterRoleBinding,将预设用户 kubelet-bootstrap 与内置的ClusterRole system:node-bootstrapper 绑定到一起,使其能够发起 CSR 请求。

1 2 3 4 5 6 7 [root@master1 work]# cat > token.csv << EOF $ (head -c 16 /dev/urandom | od -An -t x | tr -d ' ' ),kubelet-bootstrap,10001,"system:kubelet-bootstrap" EOF # 格式:token,用户名,UID,用户组 [root@master1 work]# cat token.csv c13d0ed83fbeb79f18ef50a60f3646e9,kubelet-bootstrap,10001,"system:kubelet-bootstrap"

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 [ root@master1 work] # cat kube-apiserver-csr.json{ "CN" : "kubernetes" , "hosts" : [ "127.0.0.1" , "192.168.1.180" , "192.168.1.181" , "192.168.1.182" , "192.168.1.183" , "192.168.1.199" , "10.255.0.1" , "kubernetes" , "kubernetes.default" , "kubernetes.default.svc" , "kubernetes.default.svc.cluster" , "kubernetes.default.svc.cluster.local" ] , "key" : { "algo" : "rsa" , "size" : 2048 } , "names" : [ { "C" : "CN" , "ST" : "Hubei" , "L" : "Wuhan" , "O" : "k8s" , "OU" : "system" } ] } # 注: 如果 hosts 字段不为空则需要指定授权使用该证书的 IP 或域名列表。 由于该证书后续被kubernetes master 集群使用,需要将 master 节点的 IP 都填上,同时还需要填写 service 网络的首个IP。(一般是 kube-apiserver 指定的 service-cluster-ip-range 网段的第一个 IP,如 10.255 .0 .1 )

1 2 3 4 5 6 7 8 9 10 [root@master1 work]# cfssl gencert -ca=ca.pem -ca-key=ca-key.pem -config=ca-config.json -profile=kubernetes kube-apiserver-csr.json | cfssljson -bare kube-apiserver 2023/07/17 21:14:49 [INFO] generate received request 2023/07/17 21:14:49 [INFO] received CSR 2023/07/17 21:14:49 [INFO] generating key: rsa-2048 2023/07/17 21:14:49 [INFO] encoded CSR 2023/07/17 21:14:49 [INFO] signed certificate with serial number 60558345437536204224759334781081714276751605494 2023/07/17 21:14:49 [WARNING] This certificate lacks a "hosts" field. This makes it unsuitable for websites. For more information see the Baseline Requirements for the Issuance and Management of Publicly-Trusted Certificates, v.1.1.6, from the CA/Browser Forum (https://cabforum.org); specifically, section 10.2.3 ("Information Requirements").

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 [root@master1 work] KUBE_APISERVER_OPTS="--enable-admission-plugins=NamespaceLifecycle,NodeRestriction,LimitRanger,ServiceAccount,DefaultStorageClass,ResourceQuota \ --anonymous-auth=false \ --bind-address=192.168.1.180 \ --secure-port=6443 \ --advertise-address=192.168.1.180 \ --insecure-port=0 \ --authorization-mode=Node,RBAC \ --runtime-config=api/all=true \ --enable-bootstrap-token-auth \ --service-cluster-ip-range=10.255.0.0/16 \ --token-auth-file=/etc/kubernetes/token.csv \ --service-node-port-range=30000-50000 \ --tls-cert-file=/etc/kubernetes/ssl/kube-apiserver.pem \ --tls-private-key-file=/etc/kubernetes/ssl/kube-apiserver-key.pem \ --client-ca-file=/etc/kubernetes/ssl/ca.pem \ --kubelet-client-certificate=/etc/kubernetes/ssl/kube-apiserver.pem \ --kubelet-client-key=/etc/kubernetes/ssl/kube-apiserver-key.pem \ --service-account-key-file=/etc/kubernetes/ssl/ca-key.pem \ --service-account-signing-key-file=/etc/kubernetes/ssl/ca-key.pem \ --service-account-issuer=https://kubernetes.default.svc.cluster.local \ --etcd-cafile=/etc/etcd/ssl/ca.pem \ --etcd-certfile=/etc/etcd/ssl/etcd.pem \ --etcd-keyfile=/etc/etcd/ssl/etcd-key.pem \ --etcd-servers=https://192.168.1.180:2379,https://192.168.1.181:2379,https://192.168.1.182:2379 \ --enable-swagger-ui=true \ --allow-privileged=true \ --apiserver-count=3 \ --audit-log-maxage=30 \ --audit-log-maxbackup=3 \ --audit-log-maxsize=100 \ --audit-log-path=/var/log/kube-apiserver-audit.log \ --event-ttl=1h \ --alsologtostderr=true \ --logtostderr=false \ --log-dir=/var/log/kubernetes \ --v=4" --logtostderr:启用日志 --v:日志等级 --log-dir:日志目录 --etcd-servers:etcd 集群地址 --bind-address:监听地址 --secure-port:https 安全端口 --advertise-address:集群通告地址 --allow-privileged:启用授权 --service-cluster-ip-range:Service 虚拟 IP 地址段 --enable-admission-plugins:准入控制模块 --authorization-mode:认证授权,启用 RBAC 授权和节点自管理 --enable-bootstrap-token-auth:启用 TLS bootstrap 机制 --token-auth-file:bootstrap token 文件 --service-node-port-range:Service nodeport 类型默认分配端口范围 --kubelet-client-xxx:apiserver 访问 kubelet 客户端证书 --tls-xxx-file:apiserver https 证书 --etcd-xxxfile:连接 Etcd 集群证书 – -audit-log-xxx:审计日志

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 [root@master1 work]# cat kube-apiserver.service [Unit] Description=Kubernetes API Server Documentation=https://github.com/kubernetes/kubernetes After=etcd.service Wants=etcd.service [Service] EnvironmentFile=-/etc/kubernetes/kube-apiserver.conf ExecStart=/usr/local/bin/kube-apiserver $KUBE_APISERVER_OPTS Restart=on-failure RestartSec=5 Type=notify LimitNOFILE=65536 [Install] WantedBy=multi-user.target

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 63 64 65 66 67 68 69 70 71 72 73 74 75 76 77 78 79 80 81 82 83 84 85 86 87 88 89 90 91 92 93 94 95 96 97 98 99 100 101 102 103 104 [root@master1 work]# cp ca*.pem /etc/kubernetes/ssl [root@master1 work]# cp kube-apiserver*.pem /etc/kubernetes/ssl/ [root@master1 work]# cp token.csv /etc/kubernetes/ [root@master1 work]# cp kube-apiserver.conf /etc/kubernetes/ [root@master1 work]# cp kube-apiserver.service /usr/lib/systemd/system/ [root@master1 work]# rsync -vaz token.csv master2:/etc/kubernetes/ [root@master1 work]# rsync -vaz token.csv master3:/etc/kubernetes/ [root@master1 work]# rsync -vaz kube-apiserver*.pem master2:/etc/kubernetes/ssl/ [root@master1 work]# rsync -vaz kube-apiserver*.pem master3:/etc/kubernetes/ssl/ [root@master1 work]# rsync -vaz ca*.pem master2:/etc/kubernetes/ssl/ [root@master1 work]# rsync -vaz ca*.pem master3:/etc/kubernetes/ssl/ [root@master1 work]# rsync -vaz kube-apiserver.conf master2:/etc/kubernetes/ [root@master1 work]# rsync -vaz kube-apiserver.conf master3:/etc/kubernetes/ [root@master1 work]# rsync -vaz kube-apiserver.service master2:/usr/lib/systemd/system/ [root@master1 work]# rsync -vaz kube-apiserver.service master3:/usr/lib/systemd/system/ # 注:master2 和 master3 配置文件 kube-apiserver.conf 的 IP 地址修改为实际的本机 IP [root@master2 ~]# cat /etc/kubernetes/kube-apiserver.conf KUBE_APISERVER_OPTS="--enable-admission-plugins=NamespaceLifecycle,NodeRestriction,LimitRanger,ServiceAccount,DefaultStorageClass,ResourceQuota \ --anonymous-auth=false \ --bind-address=192.168.1.181 \ --secure-port=6443 \ --advertise-address=192.168.1.181 \ --insecure-port=0 \ --authorization-mode=Node,RBAC \ --runtime-config=api/all=true \ --enable-bootstrap-token-auth \ --service-cluster-ip-range=10.255.0.0/16 \ --token-auth-file=/etc/kubernetes/token.csv \ --service-node-port-range=30000-50000 \ --tls-cert-file=/etc/kubernetes/ssl/kube-apiserver.pem \ --tls-private-key-file=/etc/kubernetes/ssl/kube-apiserver-key.pem \ --client-ca-file=/etc/kubernetes/ssl/ca.pem \ --kubelet-client-certificate=/etc/kubernetes/ssl/kube-apiserver.pem \ --kubelet-client-key=/etc/kubernetes/ssl/kube-apiserver-key.pem \ --service-account-key-file=/etc/kubernetes/ssl/ca-key.pem \ --service-account-signing-key-file=/etc/kubernetes/ssl/ca-key.pem \ --service-account-issuer=https://kubernetes.default.svc.cluster.local \ --etcd-cafile=/etc/etcd/ssl/ca.pem \ --etcd-certfile=/etc/etcd/ssl/etcd.pem \ --etcd-keyfile=/etc/etcd/ssl/etcd-key.pem \ --etcd-servers=https://192.168.1.180:2379,https://192.168.1.181:2379,https://192.168.1.182:2379 \ --enable-swagger-ui=true \ --allow-privileged=true \ --apiserver-count=3 \ --audit-log-maxage=30 \ --audit-log-maxbackup=3 \ --audit-log-maxsize=100 \ --audit-log-path=/var/log/kube-apiserver-audit.log \ --event-ttl=1h \ --alsologtostderr=true \ --logtostderr=false \ --log-dir=/var/log/kubernetes \ --v=4" [root@master3 ~]# cat /etc/kubernetes/kube-apiserver.conf KUBE_APISERVER_OPTS="--enable-admission-plugins=NamespaceLifecycle,NodeRestriction,LimitRanger,ServiceAccount,DefaultStorageClass,ResourceQuota \ --anonymous-auth=false \ --bind-address=192.168.1.182 \ --secure-port=6443 \ --advertise-address=192.168.1.182 \ --insecure-port=0 \ --authorization-mode=Node,RBAC \ --runtime-config=api/all=true \ --enable-bootstrap-token-auth \ --service-cluster-ip-range=10.255.0.0/16 \ --token-auth-file=/etc/kubernetes/token.csv \ --service-node-port-range=30000-50000 \ --tls-cert-file=/etc/kubernetes/ssl/kube-apiserver.pem \ --tls-private-key-file=/etc/kubernetes/ssl/kube-apiserver-key.pem \ --client-ca-file=/etc/kubernetes/ssl/ca.pem \ --kubelet-client-certificate=/etc/kubernetes/ssl/kube-apiserver.pem \ --kubelet-client-key=/etc/kubernetes/ssl/kube-apiserver-key.pem \ --service-account-key-file=/etc/kubernetes/ssl/ca-key.pem \ --service-account-signing-key-file=/etc/kubernetes/ssl/ca-key.pem \ --service-account-issuer=https://kubernetes.default.svc.cluster.local \ --etcd-cafile=/etc/etcd/ssl/ca.pem \ --etcd-certfile=/etc/etcd/ssl/etcd.pem \ --etcd-keyfile=/etc/etcd/ssl/etcd-key.pem \ --etcd-servers=https://192.168.1.180:2379,https://192.168.1.181:2379,https://192.168.1.182:2379 \ --enable-swagger-ui=true \ --allow-privileged=true \ --apiserver-count=3 \ --audit-log-maxage=30 \ --audit-log-maxbackup=3 \ --audit-log-maxsize=100 \ --audit-log-path=/var/log/kube-apiserver-audit.log \ --event-ttl=1h \ --alsologtostderr=true \ --logtostderr=false \ --log-dir=/var/log/kubernetes \ --v=4"

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 [root@master1 ~]# systemctl daemon-reload && systemctl enable --now kube-apiserver.service [root@master2 ~]# systemctl daemon-reload && systemctl enable --now kube-apiserver.service [root@master3 ~]# systemctl daemon-reload && systemctl enable --now kube-apiserver.service [root@master1 work]# curl --insecure https://192.168.1.180:6443/ { "kind": "Status", "apiVersion": "v1", "metadata": { }, "status": "Failure", "message": "Unauthorized", "reason": "Unauthorized", "code": 401 } # 上面看到 401,这个是正常的的状态,还没认证

部署kubectl组件

Kubectl 是客户端工具,操作 k8s 资源的,如增删改查等。

Kubectl 操作资源的时候,怎么知道连接到哪个集群,需要一个文件/etc/kubernetes/admin.conf,kubectl会根据这个文件的配置,去访问 k8s 资源。/etc/kubernetes/admin.con 文件记录了访问的 k8s 集群,和用到的证书。

可以设置一个环境变量 KUBECONFIG

也可以按照下面方法,这个是在 kubeadm 初始化 k8s 的时候会告诉我们要用的一个方法

如果设置了 KUBECONFIG,那就会先找到 KUBECONFIG 去操作 k8s,如果没有 KUBECONFIG 变量,那就会使用/root/.kube/config 文件决定管理哪个 k8s 集群的资源

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 [ root@master1 work] # cat admin-csr.json { "CN" : "admin" , "hosts" : [ ] , "key" : { "algo" : "rsa" , "size" : 2048 } , "names" : [ { "C" : "CN" , "ST" : "Hubei" , "L" : "Wuhan" , "O" : "system:masters" , "OU" : "system" } ] }

说明: 后续 kube-apiserver 使用 RBAC 对客户端(如 kubelet、kube-proxy、Pod)请求进行授权;kube-apiserver 预 定 义 了 一 些 RBAC 使 用 的 RoleBindings , 如 cluster-admin 将 Group system:masters 与 Role cluster-admin 绑定,该 Role 授予了调用 kube-apiserver 的所有 API 的权限; O 指定该证书的 Group 为 system:masters,kubelet 使用该证书访问 kube-apiserver 时 ,由于证书被 CA 签名,所以认证通过,同时由于证书用户组为经过预授权的 system:masters,所以被授予访问所有 API 的权限;

注: 这个 admin 证书,是将来生成管理员用的 kube config 配置文件用的,现在我们一般建议使用 RBAC 来对 kubernetes 进行角色权限控制,kubernetes 将证书中的 CN 字段 作为 User,O 字段作为 Group;”O”: “system:masters”, 必须是 system:masters,否则后面 kubectl create clusterrolebinding 报错。

证书 O 配置为 system:masters 在集群内部 cluster-admin 的 clusterrolebinding 将system:masters 组和 cluster-admin clusterrole 绑定在一起

1 2 3 4 5 6 7 8 9 10 11 12 13 [root@master1 work]# cfssl gencert -ca=ca.pem -ca-key=ca-key.pem -config=ca-config.json -profile=kubernetes admin-csr.json | cfssljson -bare admin 2023/07/18 09:36:33 [INFO] generate received request 2023/07/18 09:36:33 [INFO] received CSR 2023/07/18 09:36:33 [INFO] generating key: rsa-2048 2023/07/18 09:36:33 [INFO] encoded CSR 2023/07/18 09:36:33 [INFO] signed certificate with serial number 590504316254400223853731101622257961862372429191 2023/07/18 09:36:33 [WARNING] This certificate lacks a "hosts" field. This makes it unsuitable for websites. For more information see the Baseline Requirements for the Issuance and Management of Publicly-Trusted Certificates, v.1.1.6, from the CA/Browser Forum (https://cabforum.org); specifically, section 10.2.3 ("Information Requirements"). [root@master1 work]# cp admin*.pem /etc/kubernetes/ssl/

创建 kubeconfig 配置文件,比较重要

kubeconfig 为 kubectl 的配置文件,包含访问 apiserver 的所有信息,如 apiserver 地址、CA 证书和自身使用的证书(这里如果报错找不到 kubeconfig 路径,请手动复制到相应路径下,没有则忽略)

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 # 设置集群参数 [root@master1 work]# kubectl config set-cluster kubernetes --certificate-authority=ca.pem --embed-certs=true --server=https://192.168.1.180:6443 --kubeconfig=kube.config # 设置客户端认证参数 [root@master1 work]# kubectl config set-credentials admin --client-certificate=admin.pem --client-key=admin-key.pem --embed-certs=true --kubeconfig=kube.config # 设置上下文 [root@master1 work]# kubectl config set-context kubernetes --cluster=kubernetes --user=admin --kubeconfig=kube.config # 设置当前上下文 [root@master1 work]# kubectl config use-context kubernetes --kubeconfig=kube.config [root@master1 work]# mkdir ~/.kube -p [root@master1 work]# cp kube.config ~/.kube/config # 授权kubernetes证书访问kubelet api权限 [root@master1 work]# kubectl create clusterrolebinding kube-apiserver:kubelet-apis --clusterrole=system:kubelet-api-admin --user kubernetes

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 [root@master1 work]# kubectl cluster-info Kubernetes control plane is running at https://192.168.1.180:6443 To further debug and diagnose cluster problems, use 'kubectl cluster-info dump'. [root@master1 work]# kubectl get componentstatuses Warning: v1 ComponentStatus is deprecated in v1.19+ NAME STATUS MESSAGE ERROR scheduler Unhealthy Get "http://127.0.0.1:10251/healthz": dial tcp 127.0.0.1:10251: connect: connection refused controller-manager Unhealthy Get "http://127.0.0.1:10252/healthz": dial tcp 127.0.0.1:10252: connect: connection refused etcd-2 Healthy {"health":"true"} etcd-1 Healthy {"health":"true"} etcd-0 Healthy {"health":"true"} [root@master1 work]# kubectl get all --all-namespaces NAMESPACE NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE default service/kubernetes ClusterIP 10.255.0.1 <none> 443/TCP 12h

1 2 3 4 5 6 [root@master2 ~]# mkdir /root/.kube/ [root@master3 ~]# mkdir /root/.kube/ [root@master1 work]# rsync -vaz /root/.kube/config master2:/root/.kube/ [root@master1 work]# rsync -vaz /root/.kube/config master3:/root/.kube/

1 2 3 4 5 6 7 8 9 10 11 yum install -y bash-completion source /usr/share/bash-completion/bash_completion source <(kubectl completion bash) kubectl completion bash > ~/.kube/completion.bash.inc source '/root/.kube/completion.bash.inc' source $HOME/.bash_profile

部署 kube-controller-manager 组件

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 [ root@master1 work] # cat kube-controller-manager-csr.json{ "CN" : "system:kube-controller-manager" , "key" : { "algo" : "rsa" , "size" : 2048 } , "hosts" : [ "127.0.0.1" , "192.168.1.180" , "192.168.1.181" , "192.168.1.182" , "192.168.1.199" ] , "names" : [ { "C" : "CN" , "ST" : "Hubei" , "L" : "Wuhan" , "O" : "system:kube-controller-manager" , "OU" : "system" } ] }

注: hosts 列表包含所有 kube-controller-manager 节点 IP; CN 为 system:kube-controller-manager、O 为 system:kube-controller-manager,kubernetes 内置的 ClusterRoleBindings system:kube-controller-manager 赋予 kube-controller-manager 工作所需的权限

1 2 3 4 5 6 7 8 9 10 [root@master1 work]# cfssl gencert -ca=ca.pem -ca-key=ca-key.pem -config=ca-config.json -profile=kubernetes kube-controller-manager-csr.json | cfssljson -bare kube-controller-manager 2023/07/18 09:55:46 [INFO] generate received request 2023/07/18 09:55:46 [INFO] received CSR 2023/07/18 09:55:46 [INFO] generating key: rsa-2048 2023/07/18 09:55:47 [INFO] encoded CSR 2023/07/18 09:55:47 [INFO] signed certificate with serial number 28384387730590989137248799757595047228060784622 2023/07/18 09:55:47 [WARNING] This certificate lacks a "hosts" field. This makes it unsuitable for websites. For more information see the Baseline Requirements for the Issuance and Management of Publicly-Trusted Certificates, v.1.1.6, from the CA/Browser Forum (https://cabforum.org); specifically, section 10.2.3 ("Information Requirements").

创建kube-controller-manager的kubeconfig

1 2 3 4 5 6 7 8 9 10 11 # 设置集群参数 [root@master1 work]# kubectl config set-cluster kubernetes --certificate-authority=ca.pem --embed-certs=true --server=https://192.168.1.180:6443 --kubeconfig=kube-controller-manager.kubeconfig # 设置客户端认证参数 [root@master1 work]# kubectl config set-credentials system:kube-controller-manager --client-certificate=kube-controller-manager.pem --client-key=kube-controller-manager-key.pem --embed-certs=true --kubeconfig=kube-controller-manager.kubeconfig # 设置上下文参数 [root@master1 work]# kubectl config set-context system:kube-controller-manager --cluster=kubernetes --user=system:kube-controller-manager --kubeconfig=kube-controller-manager.kubeconfig # 设置当前上下文 [root@master1 work]# kubectl config use-context system:kube-controller-manager --kubeconfig=kube-controller-manager.kubeconfig

创建配置文件kube-controller-manager.conf

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 [ root@master1 work] # cat kube-controller-manager.confKUBE_CONTROLLER_MANAGER_OPTS="--port=0 \ --secure-port=10252 \ --bind-address=127.0.0.1 \ --kubeconfig=/etc/kubernetes/kube-controller-manager.kubeconfig \ --service-cluster-ip-range=10.255.0.0/16 \ --cluster-name=kubernetes \ --cluster-signing-cert-file=/etc/kubernetes/ssl/ca.pem \ --cluster-signing-key-file=/etc/kubernetes/ssl/ca-key.pem \ --allocate-node-cidrs=true \ --cluster-cidr=10.0.0.0/16 \ --experimental-cluster-signing-duration=87600h \ --root-ca-file=/etc/kubernetes/ssl/ca.pem \ --service-account-private-key-file=/etc/kubernetes/ssl/ca-key.pem \ --leader-elect=true \ --feature-gates=RotateKubeletServerCertificate=true \ --controllers=*,bootstrapsigner,tokencleaner \ --horizontal-pod-autoscaler-use-rest-clients=true \ --horizontal-pod-autoscaler-sync-period=10s \ --tls-cert-file=/etc/kubernetes/ssl/kube-controller-manager.pem \ --tls-private-key-file=/etc/kubernetes/ssl/kube-controller-manager-key.pem \ --use-service-account-credentials=true \ --alsologtostderr=true \ --logtostderr=false \ --log-dir=/var/log/kubernetes \ --v=2"

1 2 3 4 5 6 7 8 9 10 11 [root@master1 work]# cat kube-controller-manager.service [Unit] Description=Kubernetes Controller Manager Documentation=https://github.com/kubernetes/kubernetes [Service] EnvironmentFile=-/etc/kubernetes/kube-controller-manager.conf ExecStart=/usr/local/bin/kube-controller-manager $KUBE_CONTROLLER_MANAGER_OPTS Restart=on-failure RestartSec=5 [Install] WantedBy=multi-user.target

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 [root@master1 work]# cp kube-controller-manager*.pem /etc/kubernetes/ssl/ [root@master1 work]# cp kube-controller-manager.kubeconfig /etc/kubernetes/ [root@master1 work]# cp kube-controller-manager.conf /etc/kubernetes/ [root@master1 work]# cp kube-controller-manager.service /usr/lib/systemd/system/ [root@master1 work]# rsync -vaz kube-controller-manager*.pem master2:/etc/kubernetes/ssl/ [root@master1 work]# rsync -vaz kube-controller-manager*.pem master3:/etc/kubernetes/ssl/ [root@master1 work]# rsync -vaz kube-controller-manager.kubeconfig kube-controller-manager.conf master2:/etc/kubernetes/ [root@master1 work]# rsync -vaz kube-controller-manager.kubeconfig kube-controller-manager.conf master3:/etc/kubernetes/ [root@master1 work]# rsync -vaz kube-controller-manager.service master2:/usr/lib/systemd/system/ [root@master1 work]# rsync -vaz kube-controller-manager.service master3:/usr/lib/systemd/system/ [root@master1 work]# systemctl daemon-reload && systemctl enable --now kube-controller-manager.service && systemctl status kube-controller-manager.service Active: active (running) since [root@master2 ~]# systemctl daemon-reload && systemctl enable --now kube-controller-manager.service && systemctl status kube-controller-manager.service Active: active (running) since [root@master3 ~]# systemctl daemon-reload && systemctl enable --now kube-controller-manager.service && systemctl status kube-controller-manager.service Active: active (running) since

部署kube-scheduler组件

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 [ root@master1 work] # cat kube-scheduler-csr.json{ "CN" : "system:kube-scheduler" , "hosts" : [ "127.0.0.1" , "192.168.1.180" , "192.168.1.181" , "192.168.1.182" , "192.168.1.199" ] , "key" : { "algo" : "rsa" , "size" : 2048 } , "names" : [ { "C" : "CN" , "ST" : "Hubei" , "L" : "Wuhan" , "O" : "system:kube-scheduler" , "OU" : "system" } ] }

1 2 3 4 5 6 7 8 9 10 [root@master1 work]# cfssl gencert -ca=ca.pem -ca-key=ca-key.pem -config=ca-config.json -profile=kubernetes kube-scheduler-csr.json | cfssljson -bare kube-scheduler 2023/07/18 10:11:29 [INFO] generate received request 2023/07/18 10:11:29 [INFO] received CSR 2023/07/18 10:11:29 [INFO] generating key: rsa-2048 2023/07/18 10:11:30 [INFO] encoded CSR 2023/07/18 10:11:30 [INFO] signed certificate with serial number 555324633751814240953910934040569183966634377630 2023/07/18 10:11:30 [WARNING] This certificate lacks a "hosts" field. This makes it unsuitable for websites. For more information see the Baseline Requirements for the Issuance and Management of Publicly-Trusted Certificates, v.1.1.6, from the CA/Browser Forum (https://cabforum.org); specifically, section 10.2.3 ("Information Requirements").

创建kube-scheduler的kubeconfig

1 2 3 4 5 6 7 8 9 10 11 # 设置集群参数 [root@master1 work]# kubectl config set-cluster kubernetes --certificate-authority=ca.pem --embed-certs=true --server=https://192.168.1.180:6443 --kubeconfig=kube-scheduler.kubeconfig # 设置客户端认证参数 [root@master1 work]# kubectl config set-credentials system:kube-scheduler --client-certificate=kube-scheduler.pem --client-key=kube-scheduler-key.pem --embed-certs=true --kubeconfig=kube-scheduler.kubeconfig # 设置上下文参数 [root@master1 work]# kubectl config set-context system:kube-scheduler --cluster=kubernetes --user=system:kube-scheduler --kubeconfig=kube-scheduler.kubeconfig # 设置当前上下文 [root@master1 work]# kubectl config use-context system:kube-scheduler --kubeconfig=kube-scheduler.kubeconfig

创建配置文件kube-scheduler.conf

1 2 3 4 5 6 7 8 [root@master1 work]# cat kube-scheduler.conf KUBE_SCHEDULER_OPTS="--address=127.0.0.1 \ --kubeconfig=/etc/kubernetes/kube-scheduler.kubeconfig \ --leader-elect=true \ --alsologtostderr=true \ --logtostderr=false \ --log-dir=/var/log/kubernetes \ --v=2"

1 2 3 4 5 6 7 8 9 10 11 12 13 [root@master1 work]# cat kube-scheduler.service [Unit] Description=Kubernetes Scheduler Documentation=https://github.com/kubernetes/kubernetes [Service] EnvironmentFile=-/etc/kubernetes/kube-scheduler.conf ExecStart=/usr/local/bin/kube-scheduler $KUBE_SCHEDULER_OPTS Restart=on-failure RestartSec=5 [Install] WantedBy=multi-user.target

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 [root@master1 work]# cp kube-scheduler*.pem /etc/kubernetes/ssl/ [root@master1 work]# cp kube-scheduler.kubeconfig /etc/kubernetes/ [root@master1 work]# cp kube-scheduler.conf /etc/kubernetes/ [root@master1 work]# cp kube-scheduler.service /usr/lib/systemd/system/ [root@master1 work]# rsync -vaz kube-scheduler*.pem master2:/etc/kubernetes/ssl/ [root@master1 work]# rsync -vaz kube-scheduler*.pem master3:/etc/kubernetes/ssl/ [root@master1 work]# rsync -vaz kube-scheduler.kubeconfig kube-scheduler.conf master2:/etc/kubernetes/ [root@master1 work]# rsync -vaz kube-scheduler.kubeconfig kube-scheduler.conf master3:/etc/kubernetes/ [root@master1 work]# rsync -vaz kube-scheduler.service master2:/usr/lib/systemd/system/ [root@master1 work]# rsync -vaz kube-scheduler.service master3:/usr/lib/systemd/system/ [root@master1 work]# systemctl daemon-reload && systemctl enable --now kube-scheduler.service && systemctl status kube-scheduler.service [root@master2 ~]# systemctl daemon-reload && systemctl enable --now kube-scheduler.service && systemctl status kube-scheduler.service [root@master3 ~]# systemctl daemon-reload && systemctl enable --now kube-scheduler.service && systemctl status kube-scheduler.service

导入离线镜像压缩包

把 pause-cordns.tar.gz 上传到 node1 节点,手动解压

1 [root@node1 ~]# docker load -i pause-cordns.tar.gz

部署kubelet组件

kubelet: 每个 Node 节点上的 kubelet 定期就会调用 API Server 的 REST 接口报告自身状态,API Server接收这些信息后,将节点状态信息更新到 etcd 中。kubelet 也通过 API Server 监听 Pod 信息,从而对 Node机器上的 POD 进行管理,如创建、删除、更新 Pod

创建 kubelet-bootstrap.kubeconfig

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 [root@master1 work]# BOOTSTRAP_TOKEN=$(awk -F "," '{print $1}' /etc/kubernetes/token.csv) [root@master1 work]# echo $BOOTSTRAP_TOKEN c13d0ed83fbeb79f18ef50a60f3646e9 [root@master1 work]# rm -r kubelet-bootstrap.kubeconfig [root@master1 work]# kubectl config set-cluster kubernetes --certificate-authority=ca.pem --embed-certs=true --server=https://192.168.1.180:6443 --kubeconfig=kubelet-bootstrap.kubeconfig [root@master1 work]# kubectl config set-credentials kubelet-bootstrap --token=${BOOTSTRAP_TOKEN} --kubeconfig=kubelet-bootstrap.kubeconfig [root@master1 work]# kubectl config set-context default --cluster=kubernetes --user=kubelet-bootstrap --kubeconfig=kubelet-bootstrap.kubeconfig [root@master1 work]# kubectl config use-context default --kubeconfig=kubelet-bootstrap.kubeconfig [root@master1 work]# kubectl create clusterrolebinding kubelet-bootstrap --clusterrole=system:node-bootstrapper --user=kubelet-bootstrap

“cgroupDriver”: “systemd”要和 docker 的驱动一致

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 [ root@master1 work] # cat kubelet.json{ "kind" : "KubeletConfiguration" , "apiVersion" : "kubelet.config.k8s.io/v1beta1" , "authentication" : { "x509" : { "clientCAFile" : "/etc/kubernetes/ssl/ca.pem" } , "webhook" : { "enabled" : true , "cacheTTL" : "2m0s" } , "anonymous" : { "enabled" : false } } , "authorization" : { "mode" : "Webhook" , "webhook" : { "cacheAuthorizedTTL" : "5m0s" , "cacheUnauthorizedTTL" : "30s" } } , "address" : "192.168.1.183" , "port" : 10250 , "readOnlyPort" : 10255 , "cgroupDriver" : "systemd" , "hairpinMode" : "promiscuous-bridge" , "serializeImagePulls" : false , "featureGates" : { "RotateKubeletClientCertificate" : true , "RotateKubeletServerCertificate" : true } , "clusterDomain" : "cluster.local." , "clusterDNS" : [ "10.255.0.2" ] } # 注:kubelete.json 配置文件 address 改为各个节点的 ip 地址,在各个 work 节点上启动服务

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 [root@master1 work]# cat kubelet.service [Unit] Description=Kubernetes Kubelet Documentation=https://github.com/kubernetes/kubernetes After=docker.service Requires=docker.service [Service] WorkingDirectory=/var/lib/kubelet ExecStart=/usr/local/bin/kubelet \ --bootstrap-kubeconfig=/etc/kubernetes/kubelet-bootstrap.kubeconfig \ --cert-dir=/etc/kubernetes/ssl \ --kubeconfig=/etc/kubernetes/kubelet.kubeconfig \ --config=/etc/kubernetes/kubelet.json \ --network-plugin=cni \ --pod-infra-container-image=k8s.gcr.io/pause:3.2 \ --alsologtostderr=true \ --logtostderr=false \ --log-dir=/var/log/kubernetes \ --v=2 Restart=on-failure RestartSec=5 [Install] WantedBy=multi-user.target # 注: -hostname-override:显示名称,集群中唯一 -network-plugin:启用 CNI -kubeconfig:空路径,会自动生成,后面用于连接 apiserver -bootstrap-kubeconfig:首次启动向 apiserver 申请证书 -config:配置参数文件 -cert-dir:kubelet 证书生成目录 -pod-infra-container-image:管理 Pod 网络容器的镜像

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 [root@node1 ~]# mkdir /etc/kubernetes/ssl -p [root@master1 work]# scp kubelet-bootstrap.kubeconfig kubelet.json node1:/etc/kubernetes/ [root@master1 work]# scp ca.pem node1:/etc/kubernetes/ssl/ [root@master1 work]# scp kubelet.service node1:/usr/lib/systemd/system/ [root@node1 ~]# mkdir /var/lib/kubelet [root@node1 ~]# mkdir /var/log/kubernetes [root@node1 ~]# systemctl daemon-reload && systemctl enable --now kubelet.service && systemctl status kubelet.service # 确认 kubelet 服务启动成功后,接着到 master1 节点上 Approve 一下 bootstrap 请求。 # 执行如下命令可以看到一个 worker 节点发送了一个 CSR 请求 [root@master1 work]# kubectl get csr NAME AGE SIGNERNAME REQUESTOR CONDITION node-csr-QRwNdc_yv-IPt19eqKmAcyrLnDv86x31pubdK3vLTGI 46s kubernetes.io/kube-apiserver-client-kubelet kubelet-bootstrap Pending [root@master1 work]# kubectl certificate approve node-csr-QRwNdc_yv-IPt19eqKmAcyrLnDv86x31pubdK3vLTGI certificatesigningrequest.certificates.k8s.io/node-csr-QRwNdc_yv-IPt19eqKmAcyrLnDv86x31pubdK3vLTGI approved [root@master1 work]# kubectl get csr NAME AGE SIGNERNAME REQUESTOR CONDITION node-csr-QRwNdc_yv-IPt19eqKmAcyrLnDv86x31pubdK3vLTGI 87s kubernetes.io/kube-apiserver-client-kubelet kubelet-bootstrap Approved,Issued [root@master1 work]# kubectl get nodes NAME STATUS ROLES AGE VERSION node1 NotReady <none> 37s v1.20.7 # 注意:STATUS 是 NotReady 表示还没有安装网络插件

部署kube-proxy组件

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 [ root@master1 work] # cat kube-proxy-csr.json { "CN" : "system:kube-proxy" , "key" : { "algo" : "rsa" , "size" : 2048 } , "names" : [ { "C" : "CN" , "ST" : "Hubei" , "L" : "Wuhan" , "O" : "k8s" , "OU" : "system" } ] }

1 2 3 4 5 6 7 8 9 10 [root@master1 work]# cfssl gencert -ca=ca.pem -ca-key=ca-key.pem -config=ca-config.json -profile=kubernetes kube-proxy-csr.json | cfssljson -bare kube-proxy 2023/07/20 10:29:10 [INFO] generate received request 2023/07/20 10:29:10 [INFO] received CSR 2023/07/20 10:29:10 [INFO] generating key: rsa-2048 2023/07/20 10:29:10 [INFO] encoded CSR 2023/07/20 10:29:10 [INFO] signed certificate with serial number 441768971858777701284603976425459769356591871306 2023/07/20 10:29:10 [WARNING] This certificate lacks a "hosts" field. This makes it unsuitable for websites. For more information see the Baseline Requirements for the Issuance and Management of Publicly-Trusted Certificates, v.1.1.6, from the CA/Browser Forum (https://cabforum.org); specifically, section 10.2.3 ("Information Requirements").

1 2 3 4 5 6 7 [root@master1 work]# kubectl config set-cluster kubernetes --certificate-authority=ca.pem --embed-certs=true --server=https://192.168.1.180:6443 --kubeconfig=kube-proxy.kubeconfig [root@master1 work]# kubectl config set-credentials kube-proxy --client-certificate=kube-proxy.pem --client-key=kube-proxy-key.pem --embed-certs=true --kubeconfig=kube-proxy.kubeconfig [root@master1 work]# kubectl config set-context default --cluster=kubernetes --user=kube-proxy --kubeconfig=kube-proxy.kubeconfig [root@master1 work]# kubectl config use-context default --kubeconfig=kube-proxy.kubeconfig

1 2 3 4 5 6 7 8 9 10 [root@master1 work]# cat kube-proxy.yaml apiVersion: kubeproxy.config.k8s.io/v1alpha1 bindAddress: 192.168.1.183 clientConnection: kubeconfig: /etc/kubernetes/kube-proxy.kubeconfig clusterCIDR: 192.168.1.0/24 healthzBindAddress: 192.168.1.183:10256 kind: KubeProxyConfiguration metricsBindAddress: 192.168.1.183:10249 mode: "ipvs"

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 [root@master1 work]# cat kube-proxy.service [Unit] Description=Kubernetes Kube-Proxy Server Documentation=https://github.com/kubernetes/kubernetes After=network.target [Service] WorkingDirectory=/var/lib/kube-proxy ExecStart=/usr/local/bin/kube-proxy \ --config=/etc/kubernetes/kube-proxy.yaml \ --alsologtostderr=true \ --logtostderr=false \ --log-dir=/var/log/kubernetes \ --v=2 Restart=on-failure RestartSec=5 LimitNOFILE=65536 [Install] WantedBy=multi-user.target

1 2 3 4 5 6 7 [root@master1 work]# scp kube-proxy.kubeconfig kube-proxy.yaml node1:/etc/kubernetes/ [root@master1 work]# scp kube-proxy.service node1:/usr/lib/systemd/system/ [root@node1 ~]# mkdir -p /var/lib/kube-proxy [root@node1 ~]# systemctl daemon-reload && systemctl enable --now kube-proxy && systemctl status kube-proxy

部署calico组件

把 calico.tar.gz 上传到 node1 节点

把 caliso.yaml 上传到 master1 节点

1 2 3 4 5 6 7 8 9 10 11 12 [root@node1 ~]# docker load -i calico.tar.gz [root@master1 work]# kubectl apply -f calico.yaml [root@master1 work]# kubectl get pods -n kube-system NAME READY STATUS RESTARTS AGE calico-kube-controllers-6949477b58-s5mxf 1/1 Running 0 32s calico-node-hcghf 1/1 Running 0 31s [root@master1 work]# kubectl get nodes NAME STATUS ROLES AGE VERSION node1 Ready <none> 43m v1.20.7

部署coredns组件

把 coredns.yaml 上次到 master1 节点

1 2 3 4 5 6 7 8 9 10 11 [root@master1 work]# kubectl apply -f coredns.yaml [root@master1 work]# kubectl get pods -n kube-system NAME READY STATUS RESTARTS AGE calico-kube-controllers-6949477b58-s5mxf 1/1 Running 0 2m41s calico-node-hcghf 1/1 Running 0 2m40s coredns-7bf4bd64bd-jxxfk 1/1 Running 0 24s [root@master1 work]# kubectl get svc -n kube-system NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE kube-dns ClusterIP 10.255.0.2 <none> 53/UDP,53/TCP,9153/TCP 40s

查看集群状态

1 2 3 [root@master1 work]# kubectl get nodes NAME STATUS ROLES AGE VERSION node1 Ready <none> 46m v1.20.7

测试k8s集群部署tomcat

把 tomcat.tar.gz 和 busybox-1-28.tar.gz 上传到 node1

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 [root@node1 ~]# docker load -i busybox-1-28.tar.gz [root@node1 ~]# docker load -i tomcat.tar.gz [root@master1 ~]# cat tomcat.yaml apiVersion: v1 #pod属于k8s核心组v1 kind: Pod #创建的是一个Pod资源 metadata: #元数据 name: demo-pod #pod名字 namespace: default #pod所属的名称空间 labels: app: myapp #pod具有的标签 env: dev #pod具有的标签 spec: containers: #定义一个容器,容器是对象列表,下面可以有多个name - name: tomcat-pod-java #容器的名字 ports: - containerPort: 8080 image: tomcat:8.5-jre8-alpine #容器使用的镜像 imagePullPolicy: IfNotPresent - name: busybox image: busybox:latest command: #command是一个列表,定义的时候下面的参数加横线 - "/bin/sh" - "-c" - "sleep 3600" [root@master1 ~]# cat tomcat-service.yaml apiVersion: v1 kind: Service metadata: name: tomcat spec: type: NodePort ports: - port: 8080 nodePort: 30080 selector: app: myapp env: dev [root@master1 work]# kubectl apply -f tomcat.yaml [root@master1 work]# kubectl apply -f tomcat-service.yaml [root@master1 work]# kubectl get svc NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE kubernetes ClusterIP 10.255.0.1 <none> 443/TCP 82m tomcat NodePort 10.255.27.116 <none> 8080:30080/TCP 18s # 浏览器访问 node1:30080